搜索结果

TTSLabs

TTSLabs是一款在线语音合成与语音识别服务,提供高质量、自然流畅的语音合成和准确可靠的语音识别功能。通过简单的API调用,用户可以将文字转化为真实的语音,并且可以将语音转化为文本。TTSLabs提供多种语音风格和多国语言的支持,具有快速响应、高效稳定的特点。价格灵活透明,适用于个人开发者和企业用户。

FlowSpeech

FlowSpeech是一个免费的 AI 播客生成器,利用最新的语音合成技术将文本转换为自然人声,适合各种用户需求。它支持多种格式的输入,包括 PDF、TXT 等,方便用户快速获取信息。提供多种订阅选项,帮助创作者更高效地制作播客。

Klyra AI

Klyra AI是一款集成了AI视频生成、AI头像、AI产品照片、文本转语音、语音克隆、AI语音合成、AI博客编写、AI音乐生成等30多种强大工具的全能AI平台。该产品不仅适用于内容创作者、营销人员和教育者,还可以帮助商业用户生成视频、头像、产品照片、博客、音乐和语音。

EaseVoice Trainer

EaseVoice Trainer 是一个后端项目,旨在简化和增强语音合成与转换训练过程。该项目基于 GPT-SoVITS 进行改进,注重用户体验和系统的可维护性。其设计理念不同于原始项目,旨在提供更模块化和定制化的解决方案,适用于从小规模实验到大规模生产的多种场景。该工具可以帮助开发者和研究人员更高效地进行语音合成和转换的研究与开发。

OpenAI.fm

OpenAI.fm 是一个互动演示平台,允许开发者体验 OpenAI API 中的最新文本转语音模型gpt-4o-transcribe, gpt-4o-mini-transcribe and gpt-4o-mini-tts。该技术能够生成自然流畅的语音,使得文本内容生动而易于理解。它适用于各种应用场景,尤其是在语音助手和内容创作方面,能够帮助开发者更好地与用户沟通,提升用户体验。该产品定位于高效的语音合成,适合希望整合语音功能的开发者。

Orpheus TTS

Orpheus TTS 是一个基于 Llama-3b 模型的开源文本转语音系统,旨在提供更加自然的人类语音合成。它具备较强的语音克隆能力和情感表达能力,适合各种实时应用场景。该产品是免费的,旨在为开发者和研究者提供便捷的语音合成工具。

CSM 1B

CSM 1B 是一个基于 Llama 架构的语音生成模型,能够从文本和音频输入中生成 RVQ 音频代码。该模型主要应用于语音合成领域,具有高质量的语音生成能力。其优势在于能够处理多说话人的对话场景,并通过上下文信息生成自然流畅的语音。该模型开源,旨在为研究和教育目的提供支持,但明确禁止用于冒充、欺诈或非法活动。

Sesame CSM

CSM 是一个由 Sesame 开发的对话式语音生成模型,它能够根据文本和音频输入生成高质量的语音。该模型基于 Llama 架构,并使用 Mimi 音频编码器。它主要用于语音合成和交互式语音应用,例如语音助手和教育工具。CSM 的主要优点是能够生成自然流畅的语音,并且可以通过上下文信息优化语音输出。该模型目前是开源的,适用于研究和教育目的。

Llasa

Llasa是一个基于Llama框架的文本到语音(TTS)基础模型,专为大规模语音合成任务设计。该模型利用16万小时的标记化语音数据进行训练,具备高效的语言生成能力和多语言支持。其主要优点包括强大的语音合成能力、低推理成本和灵活的框架兼容性。该模型适用于教育、娱乐和商业场景,能够为用户提供高质量的语音合成解决方案。目前该模型在Hugging Face上免费提供,旨在推动语音合成技术的发展和应用。

Zonos

Zonos 是一个先进的文本到语音模型,支持多种语言,能够根据文本提示和说话者嵌入或音频前缀生成自然语音。它还支持语音克隆,只需几秒钟的参考音频即可准确复制说话者的声音。该模型具有高质量的语音输出(44kHz),并允许对语速、音调变化、音频质量和情绪(如快乐、恐惧、悲伤和愤怒)进行精细控制。Zonos 提供了 Python 和 Gradio 接口,方便用户快速上手,并支持通过 Docker 部署。该模型在 RTX 4090 上的实时因子约为 2 倍,适合需要高质量语音合成的应用场景。

Hailuo AI Audio

Hailuo AI Audio利用先进的语音合成技术,将文本转换为自然流畅的语音。其主要优点是能够生成高质量、富有表现力的语音,适用于多种场景,如有声读物制作、语音播报等。该产品定位为专业级音频合成工具,目前提供限时免费体验,旨在为用户提供高效、便捷的语音生成解决方案。

audiblez

Audiblez是一个利用Kokoro高质量语音合成技术,将普通电子书(.epub格式)转换为.m4b格式有声书的工具。它支持多种语言和声音,用户可以通过简单的命令行操作完成转换,极大地丰富了电子书的阅读体验,尤其适合在开车、运动等不方便阅读的场景下使用。该工具由Claudio Santini在2025年开发,遵循MIT许可证免费开源。

Synthesys

Synthesys是一个AI内容生成平台,提供AI视频、AI语音和AI图像生成服务。它通过使用先进的人工智能技术,帮助用户以更低的成本和更简单的操作生成专业级别的内容。Synthesys的产品背景基于当前市场对于高质量、低成本内容生成的需求,其主要优点包括支持多种语言的超真实语音合成、无需专业设备即可生成高清视频、以及用户友好的界面设计。平台的定价策略包括免费试用和不同级别的付费服务,定位于满足不同规模企业的内容生成需求。

小视频宝

小视频宝(ClipTurbo)是一个AI驱动的视频生成工具,旨在帮助用户轻松创建高质量的营销视频。该工具利用AI技术处理文案、翻译、图标匹配和TTS语音合成,最终使用manim渲染视频,避免了纯生成式AI被平台限流的问题。小视频宝支持多种模板,用户可以根据需要选择分辨率、帧率、宽高比或屏幕方向,模板将自动适配。此外,它还支持多种语音服务,包括内置的EdgeTTS语音。目前,小视频宝仍处于早期开发阶段,仅提供给三花AI的注册用户。

PlayNote

PlayNote是一款利用尖端AI语音合成技术,将各种文件和数据转换成音频创作的产品。它支持多种文件格式,包括PDF、CSV、TXT等文档,以及PNG、JPEG等图片格式,还有MP4、MOV等视频格式,以及WAV、MP3等音频格式。用户可以上传文件,PlayNote会将文件内容转化为音频,方便用户在各种场合下收听。这项技术的重要性在于它能够提高信息的可访问性,特别是对于视觉障碍人士或者在无法阅读的情况下需要获取信息的用户。PlayNote的背景信息显示,它是由PlayAI提供的,旨在通过技术创新提升工作效率和生活质量。关于价格,用户可以访问Pricing页面了解更多详情。

OuteTTS

OuteTTS是一个使用纯语言建模方法生成语音的实验性文本到语音模型。它的重要性在于能够通过先进的语言模型技术,将文本转换为自然听起来的语音,这对于语音合成、语音助手和自动配音等领域具有重要意义。该模型由OuteAI开发,提供了Hugging Face模型和GGUF模型的支持,并且可以通过接口进行语音克隆等高级功能。

MiniMates

MiniMates是一款轻量级的图片数字人驱动算法,能够在普通电脑上实时运行,支持语音驱动和表情驱动两种模式。它比市面上的liveportrait、EchoMimic、MuseTalk等算法快10-100倍,让用户能够通过极少的资源消耗定制自己的AI伙伴。该技术的主要优点包括极速体验、个性化定制以及嵌入终端的能力,摆脱了对Python和CUDA的依赖。MiniMates遵循MIT协议,适用于需要快速、高效的人脸动画和语音合成的应用场景。

SoundStorm

SoundStorm是由Google Research开发的一种音频生成技术,它通过并行生成音频令牌来大幅减少音频合成的时间。这项技术能够生成高质量、与语音和声学条件一致性高的音频,并且可以与文本到语义模型结合,控制说话内容、说话者声音和说话轮次,实现长文本的语音合成和自然对话的生成。SoundStorm的重要性在于它解决了传统自回归音频生成模型在处理长序列时推理速度慢的问题,提高了音频生成的效率和质量。

MaskGCT TTS Demo

MaskGCT TTS Demo 是一个基于MaskGCT模型的文本到语音(TTS)演示,由Hugging Face平台上的amphion提供。该模型利用深度学习技术,将文本转换为自然流畅的语音,适用于多种语言和场景。MaskGCT模型因其高效的语音合成能力和对多种语言的支持而受到关注。它不仅可以提高语音识别和合成的准确性,还能在不同的应用场景中提供个性化的语音服务。目前,该产品在Hugging Face平台上提供免费试用,具体价格和定位信息需进一步了解。

MiniMax

MiniMax模型矩阵是一套集成了多种AI大模型的产品,包括视频生成、音乐生成、文本生成和语音合成等,旨在通过先进的人工智能技术推动内容创作的革新。这些模型不仅能够提供高分辨率和高帧率的视频生成,还能创作各种风格的音乐,生成高质量的文本内容,以及提供超拟人音色的语音合成。MiniMax模型矩阵代表了AI在内容创作领域的前沿技术,具有高效、创新和多样化的特点,能够满足不同用户在创作上的需求。

讯飞虚拟人

讯飞虚拟人利用最新的AI虚拟形象技术,结合语音识别、语义理解、语音合成、NLP、星火大模型等AI核心技术,提供虚拟人形象资产构建、AI驱动、多模态交互的多场景虚拟人产品服务。一站式虚拟人音视频内容生产,AIGC助力创作灵活高效;在虚拟'AI演播室'中输入文本或录音,一键完成音、视频作品的输出,3分钟内渲染出稿。

Mini-Omni

Mini-Omni是一个开源的多模态大型语言模型,能够实现实时的语音输入和流式音频输出的对话能力。它具备实时语音到语音的对话功能,无需额外的ASR或TTS模型。此外,它还可以在思考的同时进行语音输出,支持文本和音频的同时生成。Mini-Omni通过'Audio-to-Text'和'Audio-to-Audio'的批量推理进一步增强性能。

speech-to-speech

speech-to-speech 是一个开源的模块化GPT4-o项目,通过语音活动检测、语音转文本、语言模型和文本转语音等连续部分实现语音到语音的转换。它利用了Transformers库和Hugging Face hub上可用的模型,提供了高度的模块化和灵活性。

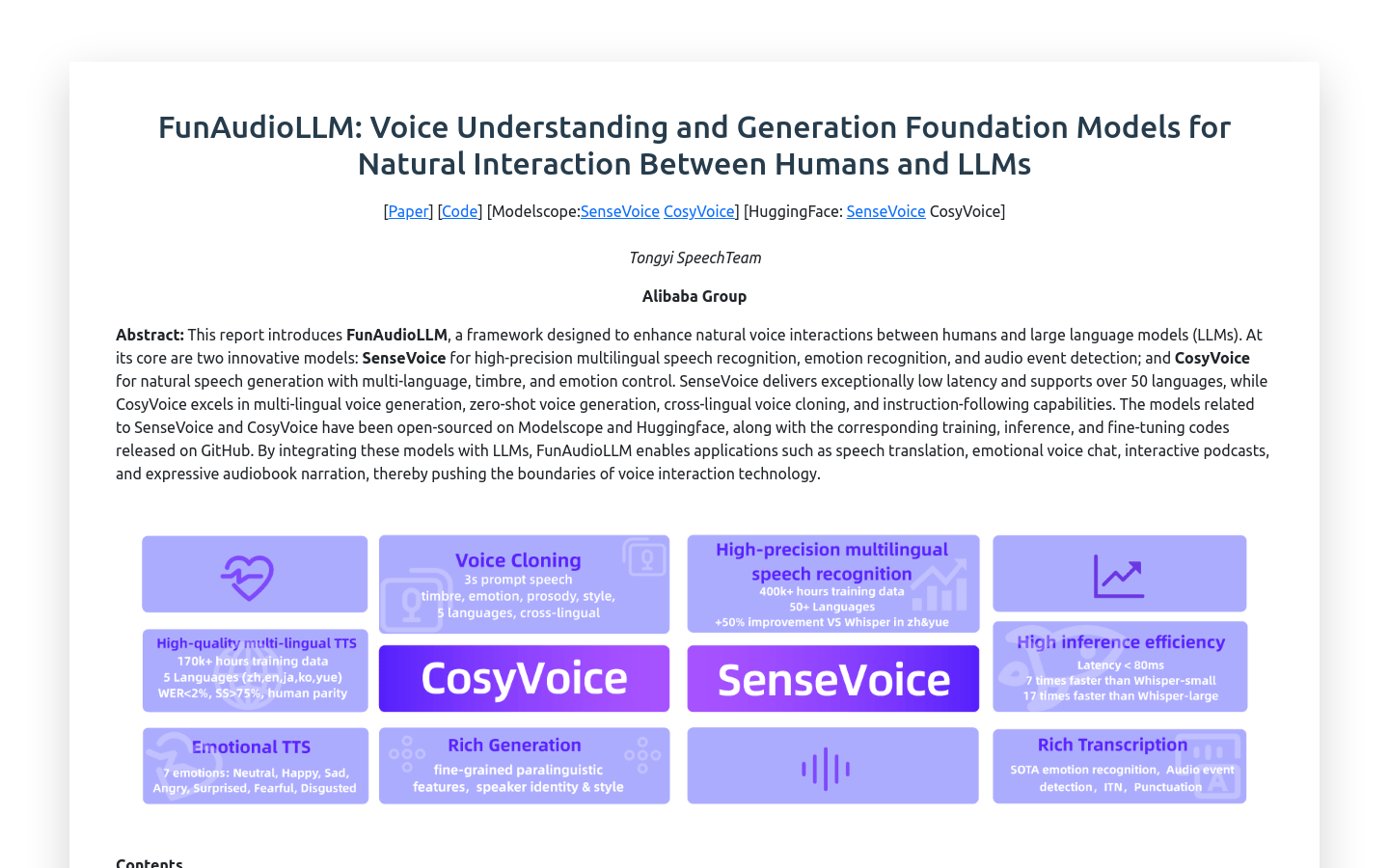

FunAudioLLM

FunAudioLLM是一个旨在增强人类与大型语言模型(Large Language Models, LLMs)之间自然语音交互的框架。它包含两个创新模型:SenseVoice负责高精度多语种语音识别、情绪识别和音频事件检测;CosyVoice负责自然语音生成,支持多语种、音色和情绪控制。SenseVoice支持超过50种语言,具有极低的延迟;CosyVoice擅长多语种语音生成、零样本上下文生成、跨语言语音克隆和指令跟随能力。相关模型已在Modelscope和Huggingface上开源,并在GitHub上发布了相应的训练、推理和微调代码。