产品详情

通过Further的NLP模型,从任何文本中获取自动化的技能建议。使用文本或音频转录的程序化技能分类,按需对内容进行分类。

主要功能

适用人群

用于从文本中提取需求技能

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

Self-Rewarding Language Models

本产品是一种自奖励语言模型,通过 LLM 作为裁判,使用模型自身提供的奖励信号进行训练。通过迭代的 DPO 训练,模型不仅可以提高遵循指令的能力,还能提供高质量的自我奖励。经过三次迭代的 Fine-tuning,本产品在 AlpacaEval 2.0 排行榜上超过了许多现有系统,包括 Claude 2、Gemini Pro 和 GPT-4 0613。这项工作虽然只是初步研究,但为模型在两个方面持续改进的可能性打开了大门。

Beagle14-7B

Beagle14-7B 是一个强大的中文语言模型,可以用于各种自然语言处理任务。它基于多个预训练模型进行了合并,包含丰富的语言知识和表达能力。Beagle14-7B 具有高效的文本生成能力和准确的语义理解能力,可以广泛应用于聊天机器人、文本生成、摘要提取等任务。Beagle14-7B 的定价信息请访问官方网址了解详情。

ahxt/LiteLlama-460M-1T

LiteLlama-460M-1T 是一个开源的人工智能模型,使用 1T 个令牌进行训练,具有 460M 个参数。它是 Meta AI 的 LLaMa 2 的一个缩减版本,用于提供更小的模型规模。

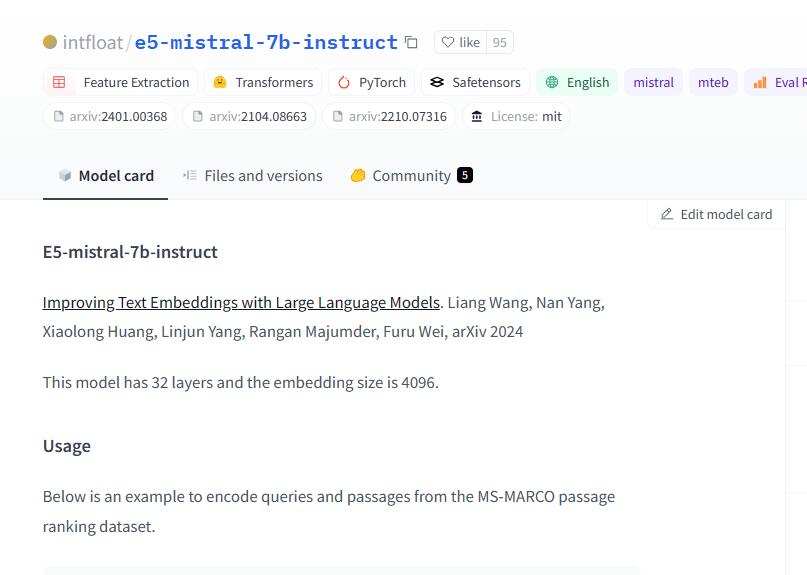

intfloat/e5-mistral-7b-instruct

E5-mistral-7b-instruct 是一个具有 32 层和 4096 个嵌入大小的文本嵌入模型。它可以用于编码查询和文档,以生成语义向量表示。该模型使用自然语言任务描述指导文本嵌入过程,可以根据不同的任务进行定制。该模型在 MS-MARCO passage ranking 数据集上进行了训练,可用于信息检索、问答等自然语言处理任务。

Megatron-LM

Megatron-LM 是由 NVIDIA 应用深度学习研究团队开发的一种强大的大规模 Transformer 模型。该产品用于大规模训练 Transformer 语言模型的持续研究。我们使用混合精度,高效的模型并行和数据并行,以及多节点的 Transformer 模型(如 GPT、BERT 和 T5)的预训练。

Google T5

Google T5 是一个统一的文本到文本转换器,通过在大型文本语料库上进行预训练,可以实现在多个 NLP 任务上取得最先进的结果。它提供了加载、预处理、混合和评估数据集的代码,并且可以用于对已发布的预训练模型进行微调。

Jina Embeddings V2 Base

Jina Embeddings V2 Base是一种英文文本嵌入模型,支持8192个序列长度。它基于Bert架构(JinaBert),支持ALiBi的对称双向变体,以允许更长的序列长度。该模型在C4数据集上进行了预训练,并在Jina AI的超过4亿个句子对和负样本的集合上进行了进一步训练。该模型适用于处理长文档的多种用例,包括长文档检索、语义文本相似度、文本重排序、推荐、RAG和LLM基于生成式搜索等。模型具有137百万个参数,推荐在单个GPU上进行推理。

Lemur

Lemur是一个开放的语言模型,旨在为语言代理提供优化的自然语言和编码能力。它平衡了自然语言和编码技能,使代理能够遵循指令、推理任务并采取实际行动。Lemur结合了自然语言和编码的优势,通过两阶段训练产生了在不同语言和编码基准上的最先进性能,超过了其他可用的开源模型,并缩小了开源模型和商业模型在代理能力上的差距。

Kosmos-2

Kosmos-2是一个多模态大型语言模型,可以将自然语言与图像、视频等多种形式的输入进行关联。它可以用于短语定位、指代表达理解、指代表达生成、图像描述和视觉问答等任务。Kosmos-2使用了GRIT数据集,该数据集包含了大量的图像-文本对,可以用于模型的训练和评估。Kosmos-2的优势在于它可以将自然语言与视觉信息进行关联,从而提高了模型的表现。

StreamingLLM

StreamingLLM是一种高效的语言模型,能够处理无限长度的输入,而不会牺牲效率和性能。它通过保留最近的令牌和注意力池,丢弃中间令牌,从而使模型能够从最近的令牌生成连贯的文本,而无需缓存重置。StreamingLLM的优势在于能够在不需要刷新缓存的情况下,从最近的对话中生成响应,而不需要依赖过去的数据。

RoleLLM

RoleLLM是一个角色扮演框架,用于构建和评估大型语言模型的角色扮演能力。它包括四个阶段:角色概要构建、基于上下文的指令生成、使用GPT进行角色提示和基于角色的指令调整。通过Context-Instruct和RoleGPT,我们创建了RoleBench,这是一个系统化和细粒度的角色级别基准数据集,包含168,093个样本。此外,RoCIT在RoleBench上产生了RoleLLaMA(英语)和RoleGLM(中文),显著提高了角色扮演能力,甚至与使用GPT-4的RoleGPT取得了可比较的结果。

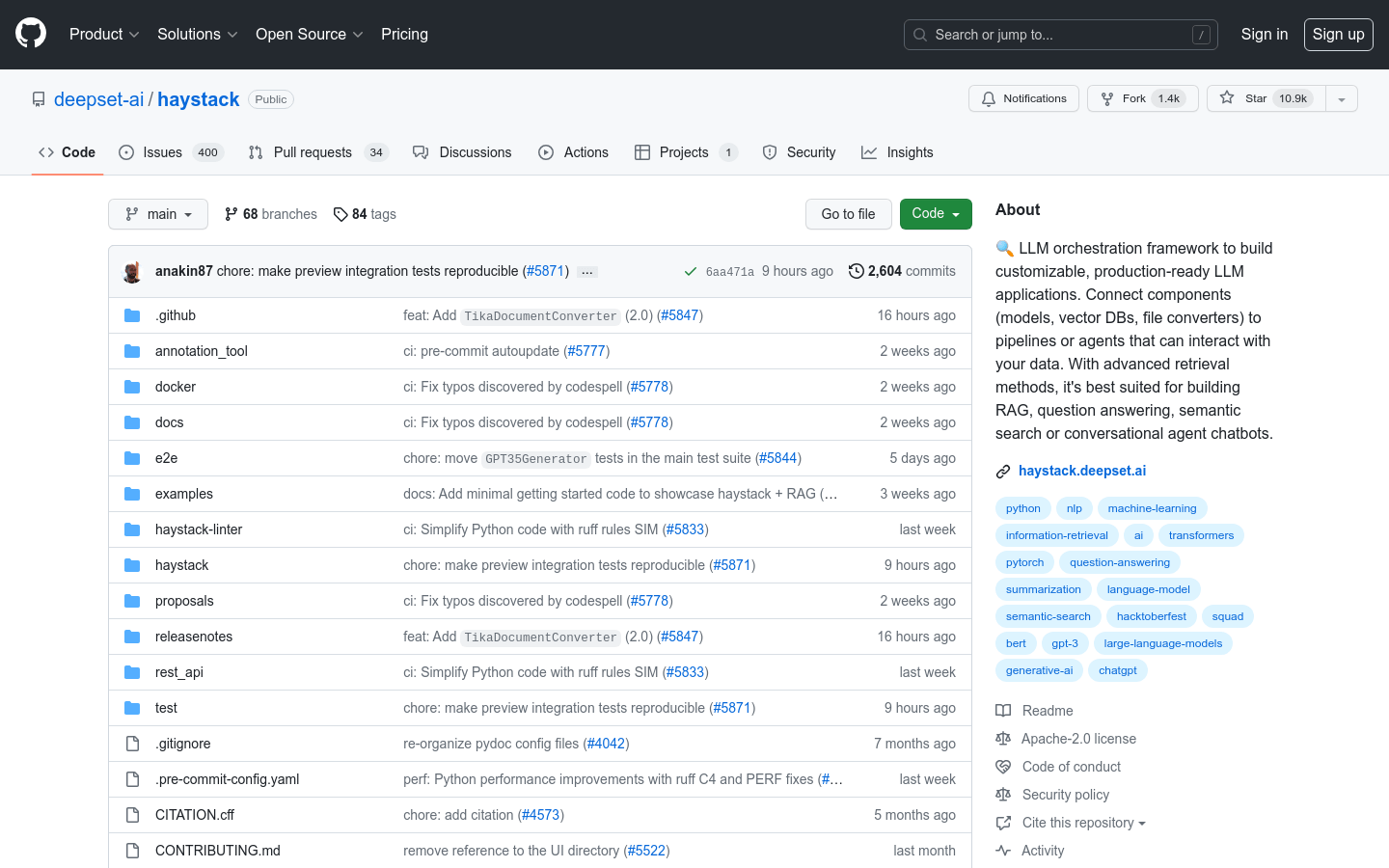

Haystack

Haystack 是一个端到端的自然语言处理框架,可以帮助您构建由 LLMs、Transformer 模型和向量搜索等驱动的应用。无论您想进行问答、答案生成、语义文档搜索,还是构建能够进行复杂决策和查询解决的工具,都可以使用 Haystack 的最先进的 NLP 模型来构建解决您的用例的端到端 NLP 应用。

LongLLaMA

LongLLaMA 是一个大型语言模型,能够处理长篇文本。它基于 OpenLLaMA,并使用 Focused Transformer (FoT) 方法进行了微调。它能够处理长达 256k 标记甚至更多的文本。我们提供了一个较小的 3B 基础模型(未经过指令调整),并在 Hugging Face 上提供了支持更长上下文的推断代码。我们的模型权重可以作为现有实现中 LLaMA 的替代品(适用于最多 2048 个标记的短上下文)。此外,我们还提供了评估结果和与原始 OpenLLaMA 模型的比较。

孟子生成式大模型(孟子 GPT)

孟子生成式大模型(孟子 GPT)是一个面向生成场景的可控大语言模型,能够通过多轮的方式帮助用户完成特定场景中的多种工作任务。它支持知识问答、多语言翻译、通用写作和金融场景任务等功能,具有更可控、更灵活、更个性、更专业的优势。具体定价和使用方式请咨询官方网站。