产品详情

GPTACG中转API提供OpenAI官方api转发服务,主打稳定性,适合对稳定性有高要求的应用场景。产品背景是为用户提供解除地区限制、超高并发支持、高性价比的企业级稳定服务,承诺不收集用户请求与返回信息。价格方面,提供不同购买额度的优惠,例如单次购买小于$500和大于等于$500的不同费率。

主要功能

使用教程

适用人群

目标受众为需要稳定API服务的企业和开发者,特别是对API稳定性有较高要求的用户。GPTACG中转API的高稳定性、高并发处理能力和技术支持,使其成为这些用户的理想选择。

使用示例

企业用户使用GPTACG中转API进行大数据分析和处理。

开发者利用API服务开发聊天机器人,提供智能对话功能。

科研人员使用API进行自然语言处理研究,提高研究效率。

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

Ministral-8B-Instruct-2410

Ministral-8B-Instruct-2410是由Mistral AI团队开发的一款大型语言模型,专为本地智能、设备端计算和边缘使用场景设计。该模型在类似的大小模型中表现优异,支持128k上下文窗口和交错滑动窗口注意力机制,能够在多语言和代码数据上进行训练,支持函数调用,词汇量达到131k。Ministral-8B-Instruct-2410模型在各种基准测试中表现出色,包括知识与常识、代码与数学以及多语言支持等方面。该模型在聊天/竞技场(gpt-4o判断)中的性能尤为突出,能够处理复杂的对话和任务。

Aria

Aria是一个多模态原生混合专家模型,具有强大的多模态、语言和编码任务性能。它在视频和文档理解方面表现出色,支持长达64K的多模态输入,能够在10秒内描述一个256帧的视频。Aria模型的参数量为25.3B,能够在单个A100(80GB)GPU上使用bfloat16精度进行加载。Aria的开发背景是满足对多模态数据理解的需求,特别是在视频和文档处理方面。它是一个开源模型,旨在推动多模态人工智能的发展。

Open-O1

Open O1是一个开源项目,旨在通过开源创新,匹配专有的强大O1模型能力。该项目通过策划一组O1风格的思考数据,用于训练LLaMA和Qwen模型,赋予了这些较小模型更强大的长期推理和解决问题的能力。随着Open O1项目的推进,我们将继续推动大型语言模型的可能性,我们的愿景是创建一个不仅能够实现类似O1的性能,而且在测试时扩展性方面也处于领先地位的模型,使高级AI能力为所有人所用。通过社区驱动的开发和对道德实践的承诺,Open O1将成为AI进步的基石,确保技术的未来发展是开放的,并对所有人有益。

GRIN-MoE

GRIN-MoE是由微软开发的混合专家(Mixture of Experts, MoE)模型,专注于提高模型在资源受限环境下的性能。该模型通过使用SparseMixer-v2来估计专家路由的梯度,与传统的MoE训练方法相比,GRIN-MoE在不依赖专家并行处理和令牌丢弃的情况下,实现了模型训练的扩展。它在编码和数学任务上表现尤为出色,适用于需要强推理能力的场景。

OneGen

OneGen是一个为大型语言模型(LLMs)设计的高效单遍生成和检索框架,用于微调生成、检索或混合任务。它的核心思想是将生成和检索任务整合到同一上下文中,通过将检索任务分配给以自回归方式生成的检索令牌,使得LLM能够在单次前向传递中执行两种任务。这种方法不仅降低了部署成本,还显著减少了推理成本,因为它避免了对查询进行两次前向传递计算的需求。

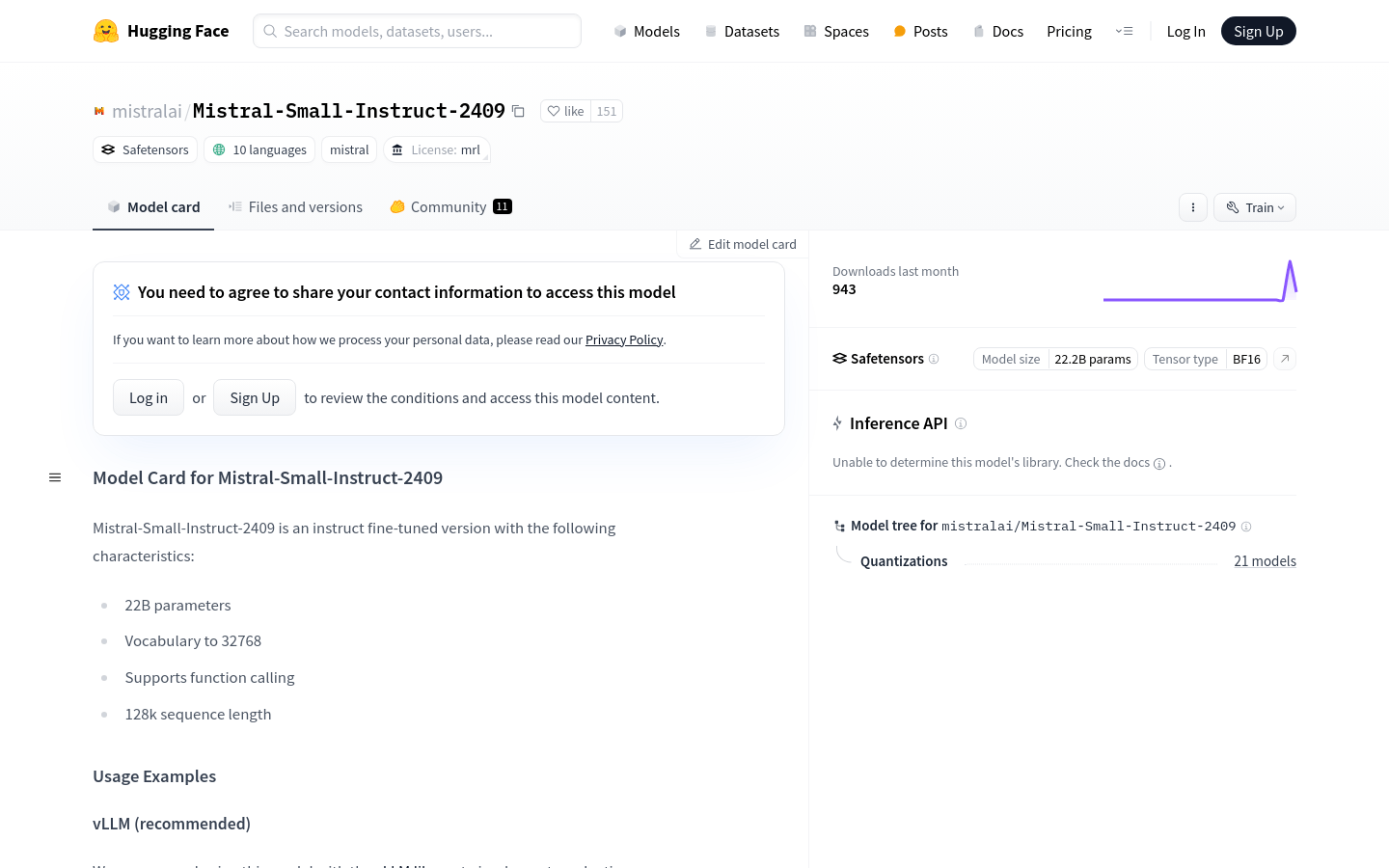

Mistral-Small-Instruct-2409

Mistral-Small-Instruct-2409是由Mistral AI Team开发的一个具有22B参数的指令式微调AI模型,支持多种语言,并能够支持高达128k的序列长度。该模型特别适用于需要长文本处理和复杂指令理解的场景,如自然语言处理、机器学习等领域。

g1

g1是一个实验性的项目,旨在通过使用Llama-3.1 70b模型在Groq硬件上创建类似于OpenAI的o1模型的推理链。这个项目展示了仅通过提示技术,就可以显著提高现有开源模型在逻辑问题解决上的能力,而无需进行复杂的训练。g1通过可视化的推理步骤,帮助模型在逻辑问题上实现更准确的推理,这对于提高人工智能的逻辑推理能力具有重要意义。

Skywork-Reward-Llama-3.1-8B

Skywork-Reward-Llama-3.1-8B是一个基于Meta-Llama-3.1-8B-Instruct架构的先进奖励模型,使用Skywork Reward Data Collection进行训练,该数据集包含80K高质量的偏好对。模型在处理复杂场景中的偏好,包括具有挑战性的偏好对方面表现出色,覆盖数学、编程和安全性等多个领域。截至2024年9月,该模型在RewardBench排行榜上位列第三。

Flux Gym

Flux Gym是一个为FLUX LoRA模型训练设计的简洁Web UI,特别适合只有12GB、16GB或20GB VRAM的设备使用。它结合了AI-Toolkit项目的易用性和Kohya Scripts的灵活性,使得用户无需复杂的终端操作即可进行模型训练。Flux Gym支持用户通过简单的界面上传图片和添加描述,然后启动训练过程。

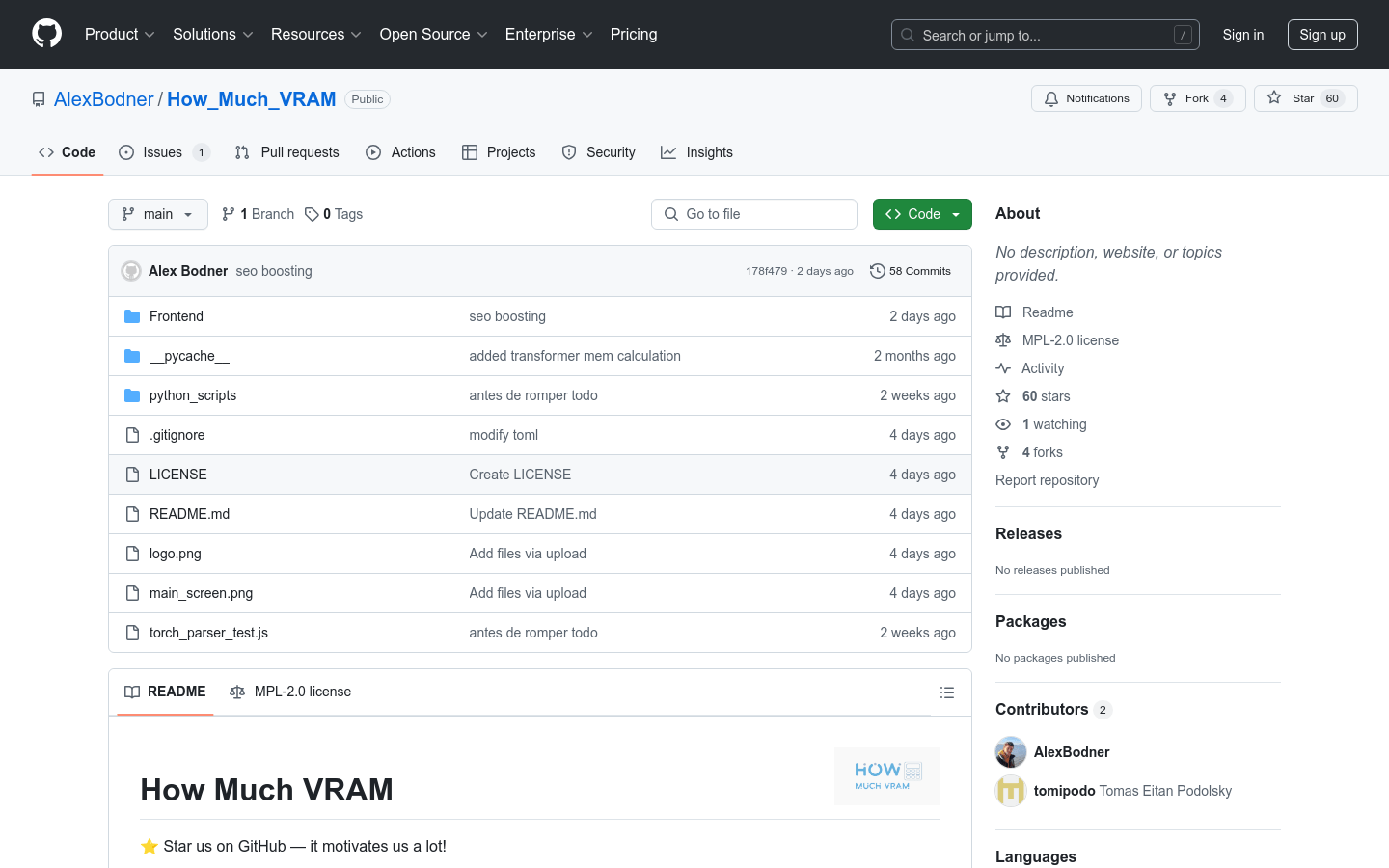

How Much VRAM

How Much VRAM 是一个开源项目,旨在帮助用户估算其模型在训练或推理过程中所需的显存量。通过这个项目,用户能够决定所需的硬件配置,而无需尝试多种配置。该项目对于需要进行深度学习模型训练的开发者和研究人员来说非常重要,因为它可以减少硬件选择的试错成本,提高效率。项目采用 MPL-2.0 许可协议,免费提供。

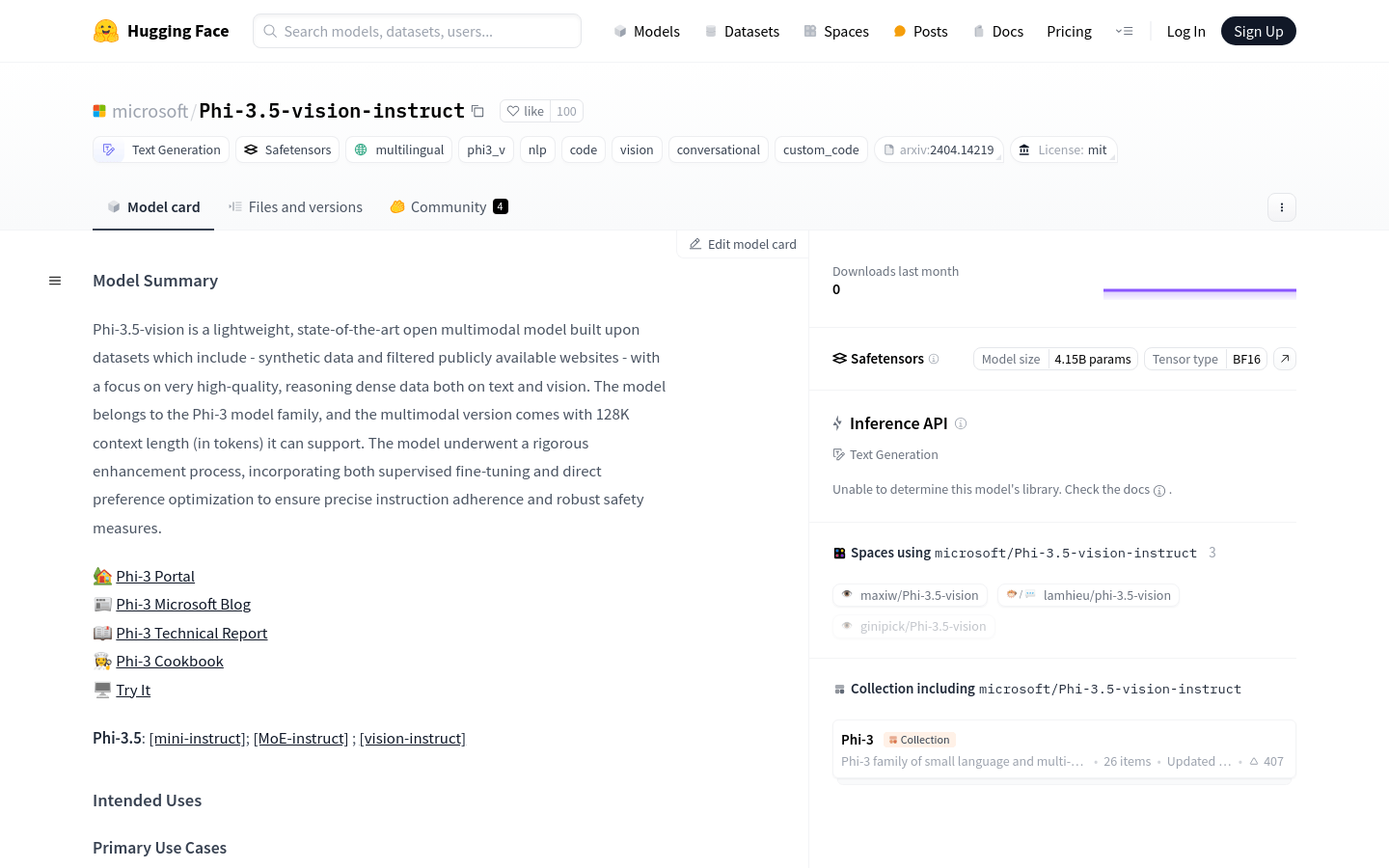

Phi-3.5-vision

Phi-3.5-vision是微软开发的轻量级、最新一代的多模态模型,基于包括合成数据和经过筛选的公开可用网站在内的数据集构建,专注于文本和视觉的高质量、密集推理数据。该模型属于Phi-3模型家族,经过严格的增强过程,结合了监督微调和直接偏好优化,以确保精确的指令遵循和强大的安全措施。

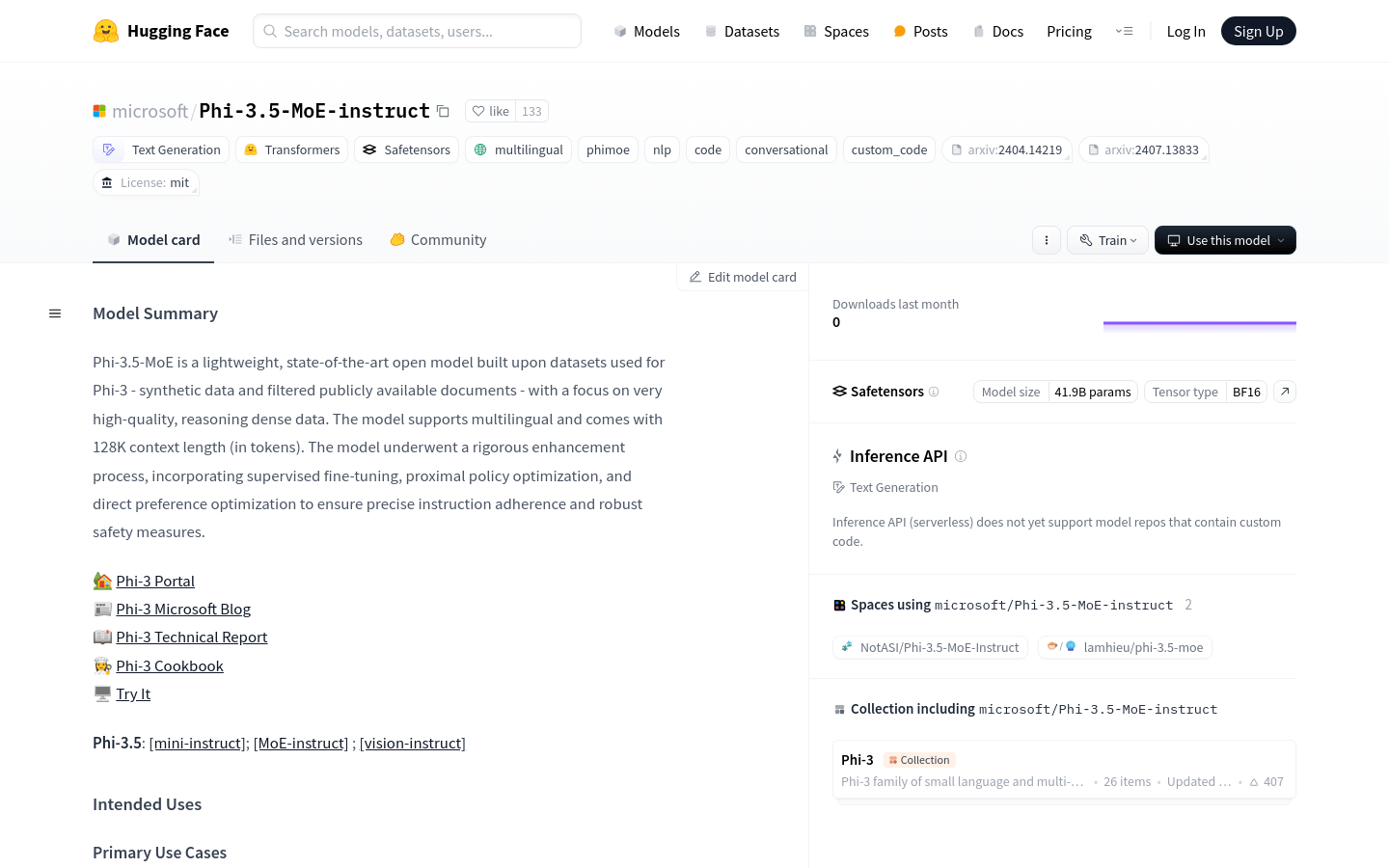

Phi-3.5-MoE-instruct

Phi-3.5-MoE-instruct是由微软开发的轻量级、多语言的AI模型,基于高质量、推理密集型数据构建,支持128K的上下文长度。该模型经过严格的增强过程,包括监督式微调、近端策略优化和直接偏好优化,以确保精确的指令遵循和强大的安全措施。它旨在加速语言和多模态模型的研究,作为生成性AI功能的构建模块。

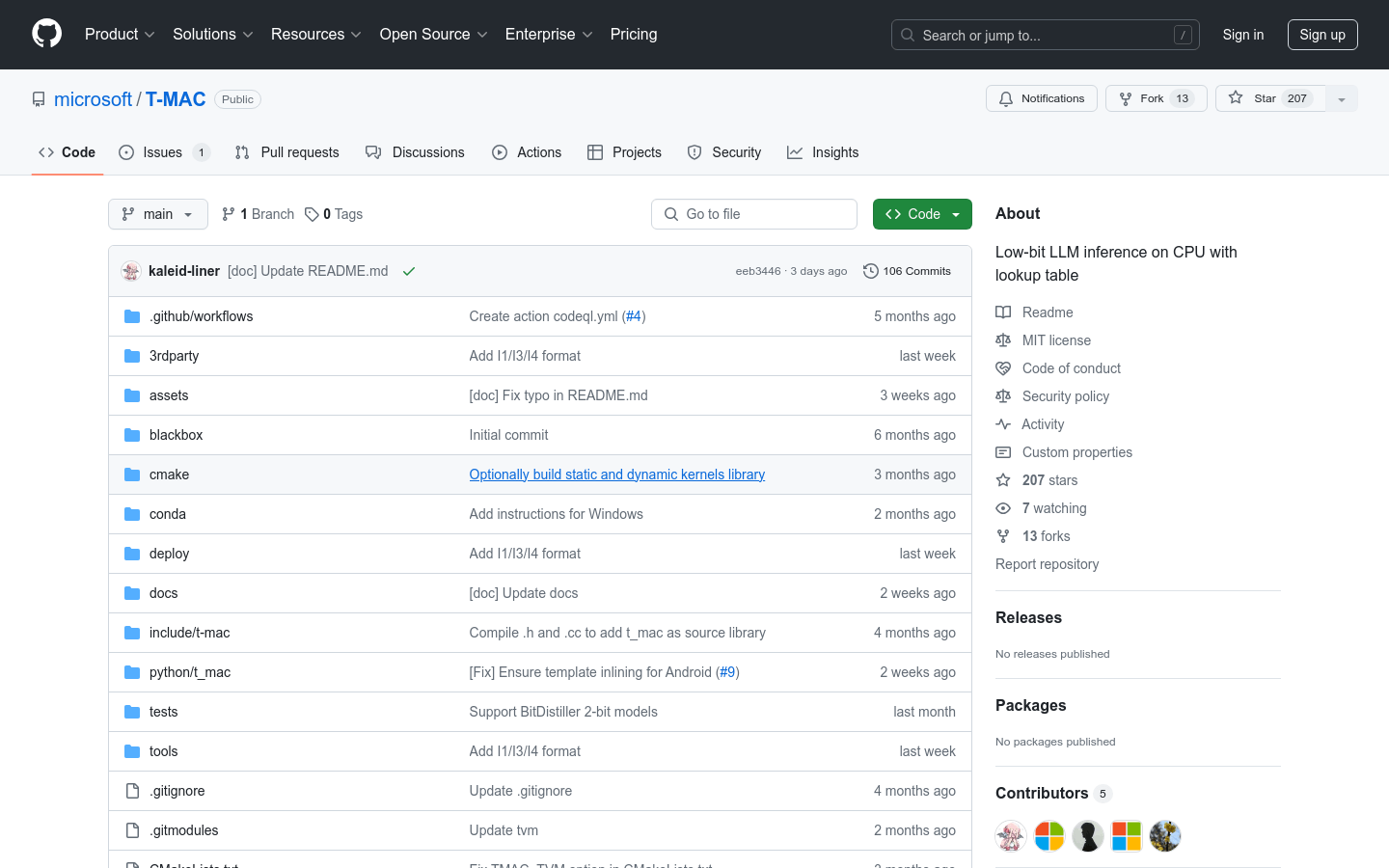

T-MAC

T-MAC是一个内核库,通过使用查找表直接支持混合精度矩阵乘法,无需去量化操作,旨在加速CPU上的低比特大型语言模型推理。它支持多种低比特模型,包括GPTQ/gguf的W4A16、BitDistiller/EfficientQAT的W2A16以及OSX/Linux/Windows上的ARM/Intel CPU的BitNet W1(.58)A8。T-MAC在Surface Laptop 7上实现了3B BitNet的令牌生成吞吐量,单核每秒20个,四核每秒48个,比现有最先进的CPU低比特框架(llama.cpp)快4~5倍。

Falcon Mamba

Falcon Mamba是由阿布扎比技术创新研究所(TII)发布的首个无需注意力机制的7B大规模模型。该模型在处理大型序列时,不受序列长度增加导致的计算和存储成本增加的限制,同时保持了与现有最先进模型相当的性能。

Gemma Scope

Gemma Scope是一套为Gemma 2的9B和2B模型设计的稀疏自编码器,它像显微镜一样帮助我们分析模型内部的激活,从而理解其背后的概念。这些自编码器可以用于研究模型的内部激活,类似于生物学家用显微镜研究植物和动物的细胞。

Meta-Llama-3.1-405B-Instruct-FP8

Meta Llama 3.1系列模型是一套预训练和指令调整的多语言大型语言模型(LLMs),包含8B、70B和405B三种规模的模型,专为多语言对话使用案例优化,性能优于许多开源和闭源聊天模型。