产品详情

Cheating LLM Benchmarks 是一个研究项目,旨在通过构建所谓的“零模型”(null models)来探索在自动语言模型(LLM)基准测试中的作弊行为。该项目通过实验发现,即使是简单的零模型也能在这些基准测试中取得高胜率,这挑战了现有基准测试的有效性和可靠性。该研究对于理解当前语言模型的局限性和改进基准测试方法具有重要意义。

主要功能

使用教程

适用人群

目标受众主要是自然语言处理(NLP)领域的研究人员、开发者以及对语言模型性能评估感兴趣的技术爱好者。这个项目为他们提供了一个平台,用于测试和理解现有语言模型的基准测试性能,以及探讨如何改进这些测试方法。

使用示例

研究人员使用该项目来测试和分析不同语言模型在特定任务上的表现。

开发者利用该项目的代码和工具来构建和评估自己的语言模型。

教育机构可能使用这个项目作为教学案例,帮助学生理解语言模型评估的复杂性。

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

AutoArena

AutoArena是一个自动化的生成式AI评估平台,专注于评估大型语言模型(LLMs)、检索增强生成(RAG)系统和生成式AI应用。它通过自动化的头对头判断来提供可信的评估,帮助用户快速、准确、经济地找到系统的最佳版本。该平台支持使用来自不同供应商的判断模型,如OpenAI、Anthropic等,也可以使用本地运行的开源权重判断模型。AutoArena还提供了Elo评分和置信区间计算,帮助用户将多次头对头投票转化为排行榜排名。此外,AutoArena支持自定义判断模型的微调,以实现更准确、特定领域的评估,并可以集成到持续集成(CI)流程中,以自动化评估生成式AI系统。

SWE-bench Verified

SWE-bench Verified是OpenAI发布的一个经过人工验证的SWE-bench子集,旨在更可靠地评估AI模型解决现实世界软件问题的能力。它通过提供代码库和问题描述,挑战AI生成解决所描述问题的补丁。这个工具的开发是为了提高模型自主完成软件工程任务的能力评估的准确性,是OpenAI准备框架中中等风险级别的关键组成部分。

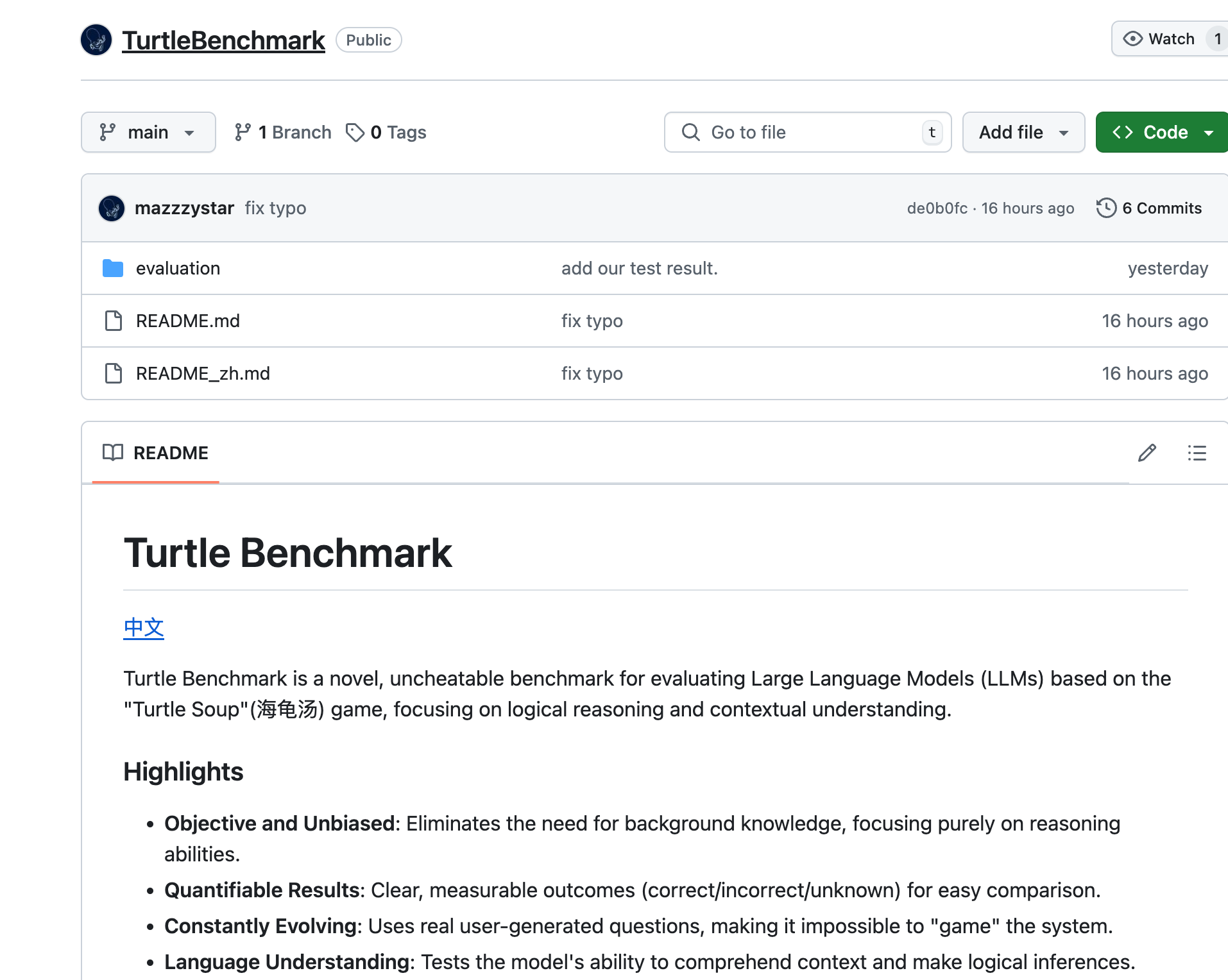

Turtle Benchmark

Turtle Benchmark是一款基于'Turtle Soup'游戏的新型、无法作弊的基准测试,专注于评估大型语言模型(LLMs)的逻辑推理和上下文理解能力。它通过消除对背景知识的需求,提供了客观和无偏见的测试结果,具有可量化的结果,并且通过使用真实用户生成的问题,使得模型无法被'游戏化'。

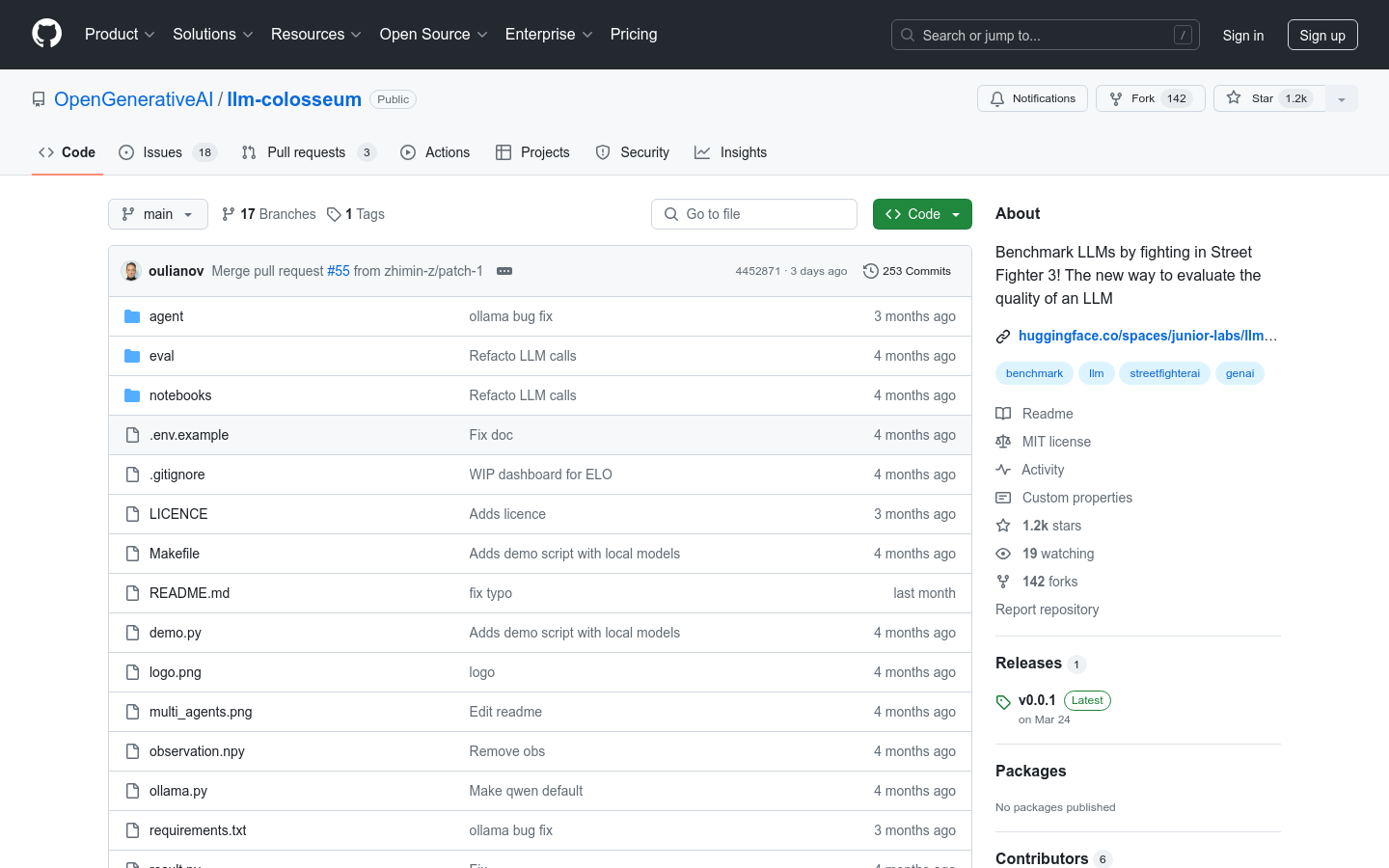

llm-colosseum

llm-colosseum是一个创新的基准测试工具,它使用街霸3游戏来评估大型语言模型(LLM)的实时决策能力。与传统的基准测试不同,这个工具通过模拟实际游戏场景来测试模型的快速反应、智能策略、创新思维、适应性和恢复力。

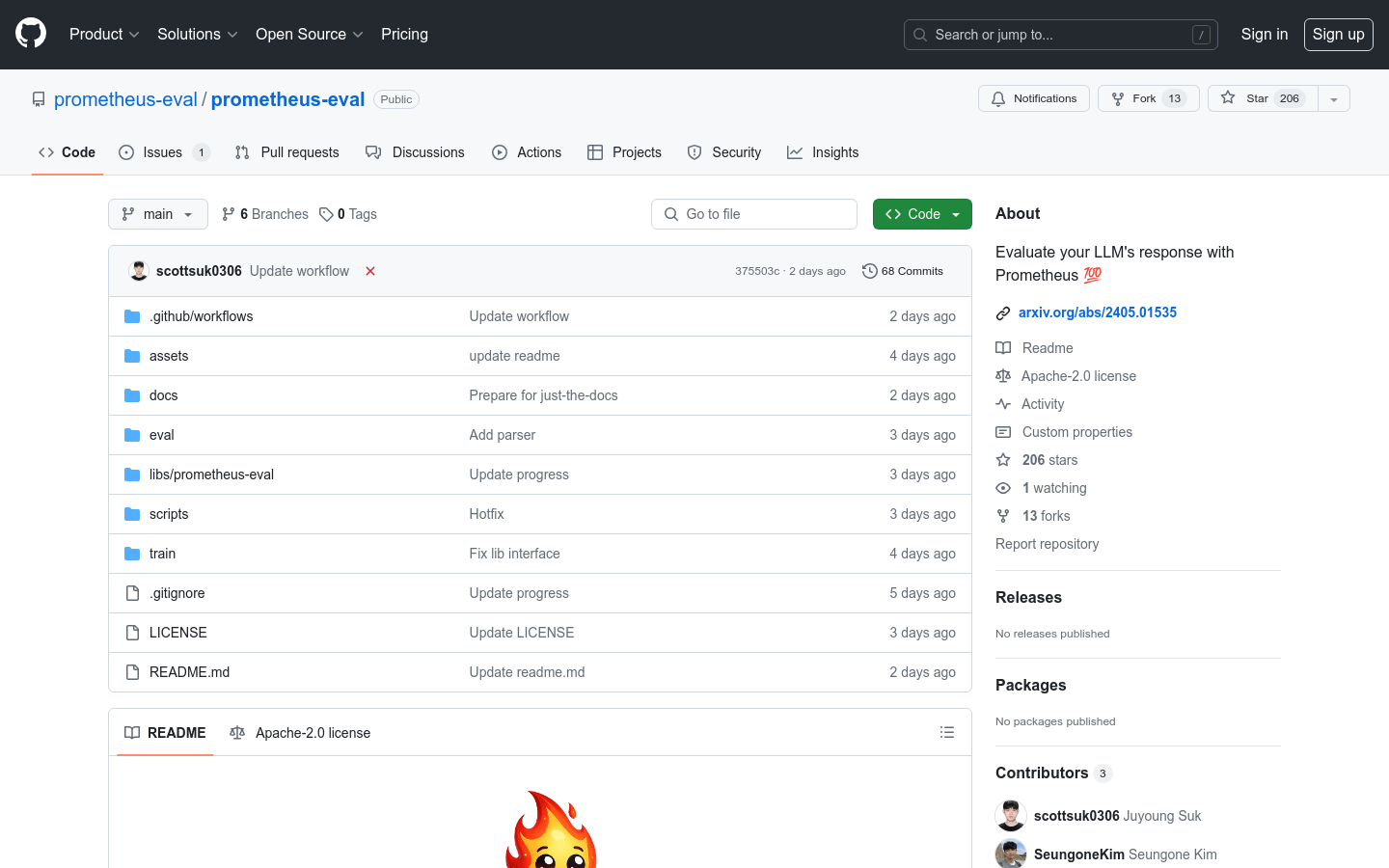

Prometheus-Eval

Prometheus-Eval 是一个用于评估大型语言模型(LLM)在生成任务中表现的开源工具集。它提供了一个简单的接口,使用 Prometheus 模型来评估指令和响应对。Prometheus 2 模型支持直接评估(绝对评分)和成对排名(相对评分),能够模拟人类判断和专有的基于语言模型的评估,解决了公平性、可控性和可负担性的问题。

Deepmark AI

Deepmark AI 是一款用于评估大型语言模型(LLM)的基准工具,可在自己的数据上对各种任务特定指标进行评估。它与 GPT-4、Anthropic、GPT-3.5 Turbo、Cohere、AI21 等领先的生成式 AI API 进行预集成。

deepeval

DeepEval提供了不同方面的度量来评估LLM对问题的回答,以确保答案是相关的、一致的、无偏见的、非有毒的。这些可以很好地与CI/CD管道集成在一起,允许机器学习工程师快速评估并检查他们改进LLM应用程序时,LLM应用程序的性能是否良好。DeepEval提供了一种Python友好的离线评估方法,确保您的管道准备好投入生产。它就像是“针对您的管道的Pytest”,使生产和评估管道的过程与通过所有测试一样简单直接。

Cognitora

Cognitora是下一代专为AI智能体设计的云平台。与传统容器平台不同,它利用Cloud Hypervisor和Firecracker等高性能微虚拟机,提供安全、轻量级且快速的AI原生计算环境。它能执行AI生成的代码,大规模自动化智能工作负载,填补了AI推理与现实世界执行之间的差距。其重要性在于为AI智能体提供了强大的计算和运行支持,让AI智能体能够更高效、安全地运行。主要优点包括高性能、安全隔离、闪电般快速的启动时间、支持多语言、先进的SDK和工具等。该平台面向AI开发者和企业,致力于为AI智能体提供全面的计算资源和工具。价格方面,用户注册可获得5000个免费积分用于测试。

Macroscope

Macroscope是一款服务研发团队的编程效率工具,获3000万美元A轮融资,已公开上线。核心功能围绕代码管理与研发流程优化,通过解析代码库构建知识图谱、整合多工具生态,解决工程师非开发性工作负担重、管理者难掌握研发进度的痛点。其技术优势在于多模型协同(如OpenAI o4-mini-high与Anthropic Opus 4结合)保障代码审核精准度,且客户数据隔离加密、符合SOC 2 Type II合规,承诺不使用客户代码训练模型。定价分Teams(30美元/开发者/月,至少5席)与Enterprise(定制价)套餐,定位中小型研发团队及有定制需求的大型企业,帮助团队聚焦核心开发,提升整体研发效率。

100 Vibe Coding

100 Vibe Coding是一个教育性编程网站,专注于通过AI技术快速构建小型Web项目。它跳过复杂理论,注重实际结果,适合想快速创建真实项目的初学者。

iFlow CLI

iFlow CLI 是一款交互式终端命令行工具,旨在简化开发者与终端的交互,提升工作效率。它支持多种命令和功能,让用户能够快速执行命令和管理任务。iFlow CLI 的主要优点包括易用性、灵活性和可定制性,适合各种开发环境和项目需求。

Never lose your work again

Claude Code 检查点是Claude AI开发人员的必备伴侣应用程序。通过无缝跟踪所有代码更改,保证代码安全,永不丢失。

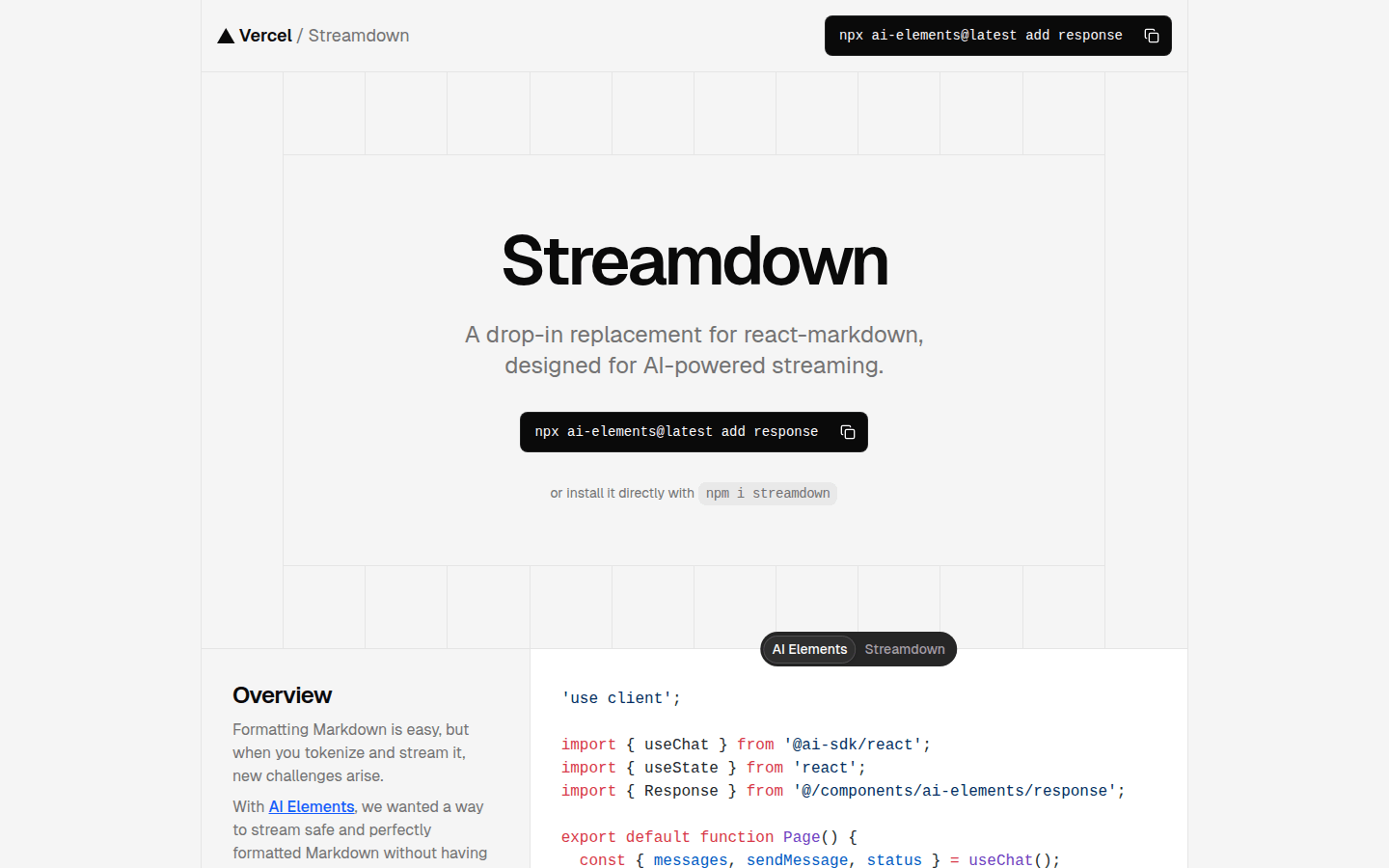

Streamdown

Streamdown是一个为AI驱动流式处理而设计的React Markdown的即插即用替代品。它解决了在标记和流式处理时出现的新挑战,可确保安全且完美格式化的Markdown内容。主要优点包括AI驱动流式处理、内置安全性、支持GitHub Flavored Markdown等。

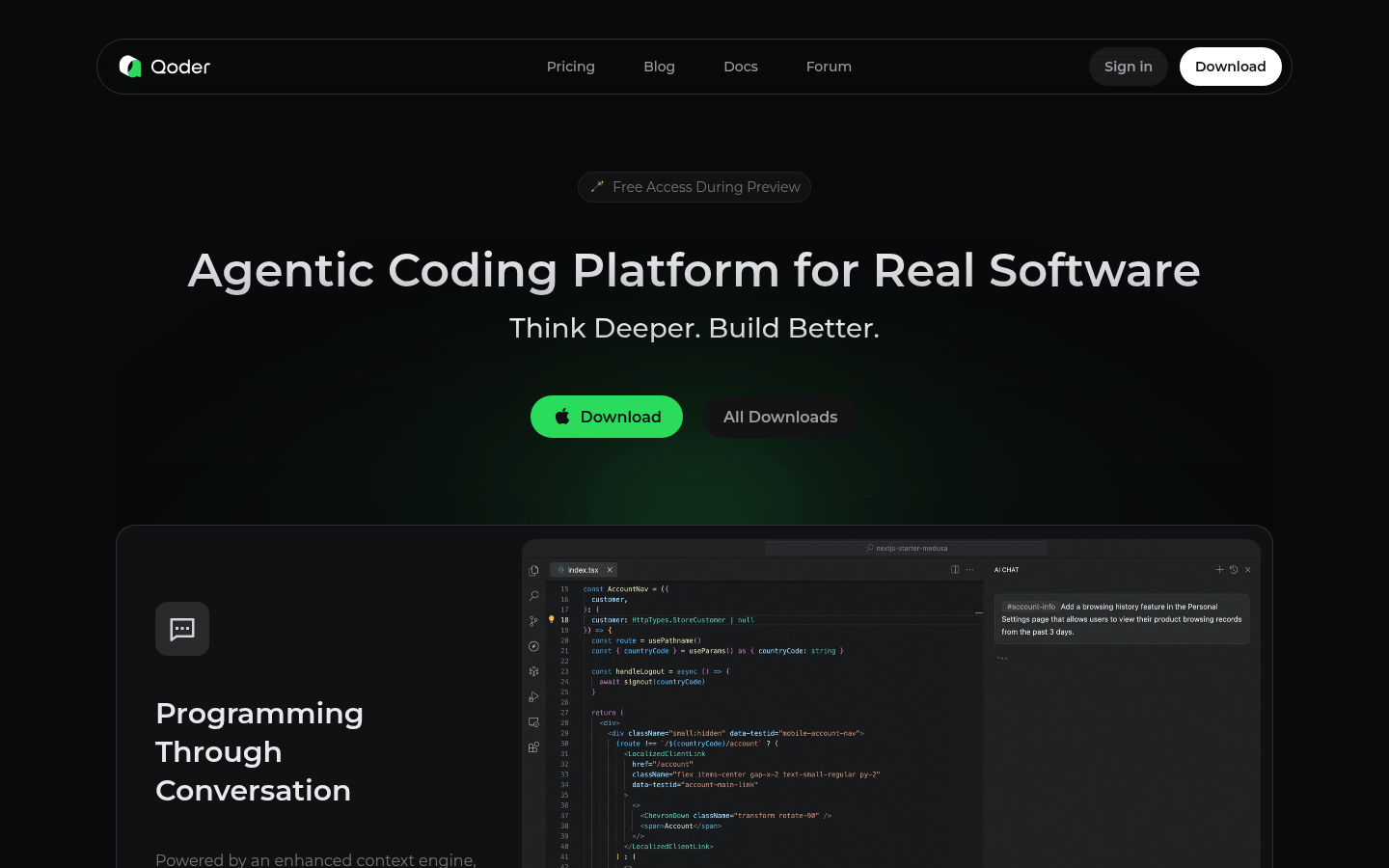

Qoder

Qoder是一个代理编码平台,通过增强的上下文引擎和智能代理无缝集成,全面了解您的代码库并系统化处理软件开发任务。支持世界上最新和最先进的AI模型:Claude、GPT、Gemini等。适用于Windows和macOS。

Compozy

Compozy是一个企业级平台,使用声明性YAML提供可扩展、可靠且成本高效的分布式工作流,简化复杂的扇出、调试和监控,以实现生产就绪的自动化。