产品详情

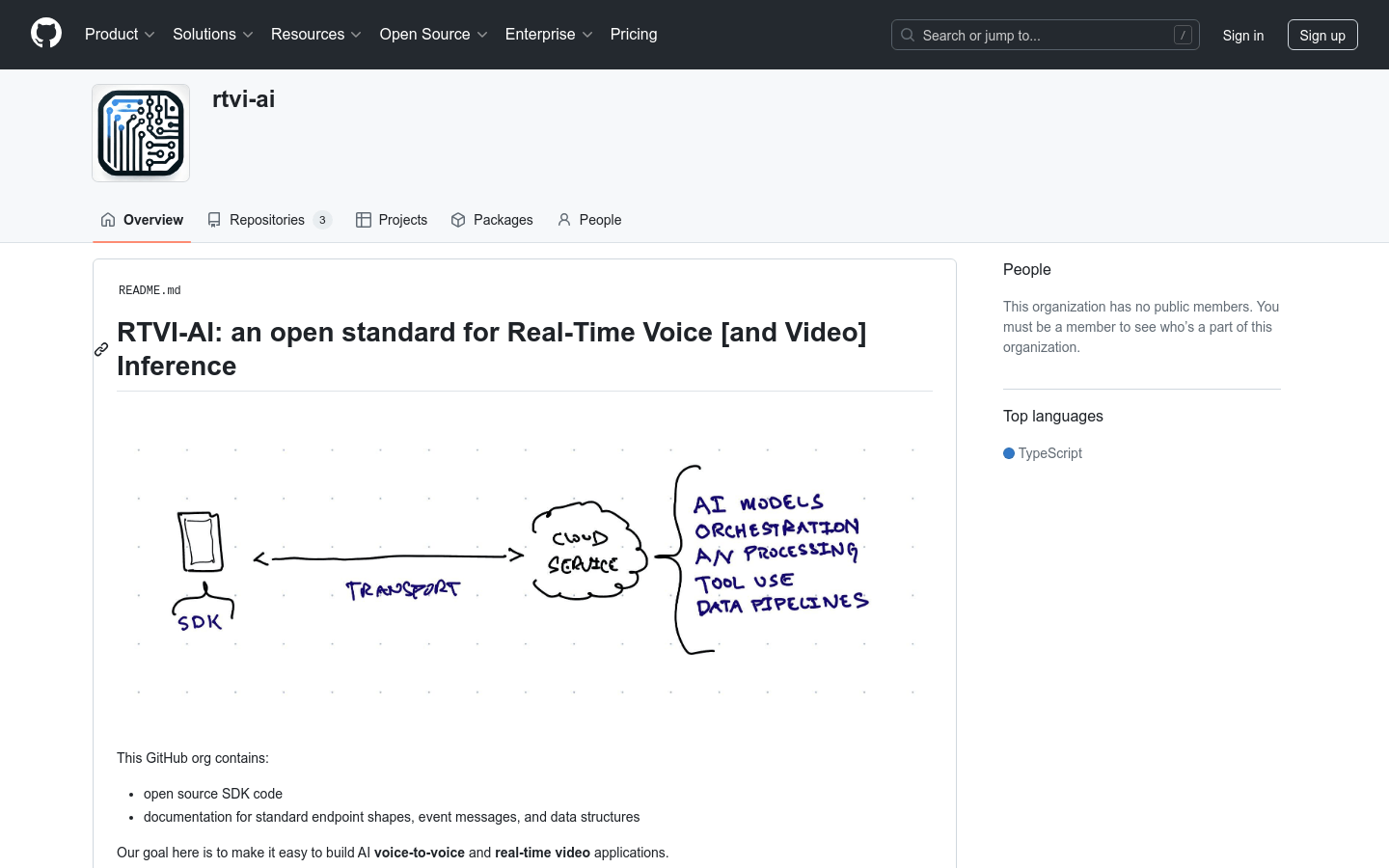

RTVI-AI是一个旨在简化构建AI语音到语音和实时视频应用的开放标准。它提供了开源SDK代码和标准端点形状、事件消息以及数据结构的文档,支持开发者使用任何推理服务,并允许推理服务利用开源工具为实时多媒体开发复杂的客户端工具。

主要功能

使用教程

适用人群

RTVI-AI适合需要开发实时语音和视频应用的开发者,特别是那些希望利用开源工具和标准来加速开发过程,并能够轻松切换或集成不同推理服务的专业人士。

使用示例

使用RTVI-AI构建的医疗咨询应用,可以收集患者信息并进行健康咨询。

集成到客户服务系统中,通过语音交互提供实时帮助和信息查询。

在教育平台中,作为辅助工具,提供实时的语音反馈和教学内容展示。

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

openai-realtime-api

openai-realtime-api是一个TypeScript客户端,用于与OpenAI的实时语音API进行交互。它提供了强类型的特性,并且是OpenAI官方JavaScript版本的完美替代品。该客户端修复了许多小错误和不一致性,并且完全兼容官方和非官方事件。它支持Node.js、浏览器、Deno、Bun、CF workers等多种环境,并且已发布到NPM。该技术的重要性在于它能够为开发者提供一种更安全、更便捷的方式来集成和使用OpenAI的实时语音功能,特别是在需要处理大量数据和请求时。

Reverb

Reverb 是一个开源的语音识别和说话人分割模型推理代码,使用 WeNet 框架进行语音识别 (ASR) 和 Pyannote 框架进行说话人分割。它提供了详细的模型描述,并允许用户从 Hugging Face 下载模型。Reverb 旨在为开发者和研究人员提供高质量的语音识别和说话人分割工具,以支持各种语音处理任务。

Realtime API

Realtime API 是 OpenAI 推出的一款低延迟语音交互API,它允许开发者在应用程序中构建快速的语音到语音体验。该API支持自然语音到语音对话,并可处理中断,类似于ChatGPT的高级语音模式。它通过WebSocket连接,支持功能调用,使得语音助手能够响应用户请求,触发动作或引入新上下文。该API的推出,意味着开发者不再需要组合多个模型来构建语音体验,而是可以通过单一API调用实现自然对话体验。

Deepgram Voice Agent API

Deepgram Voice Agent API 是一个统一的语音到语音API,它允许人类和机器之间进行自然听起来的对话。该API由行业领先的语音识别和语音合成模型提供支持,能够自然且实时地听、思考和说话。Deepgram致力于通过其语音代理API推动语音优先AI的未来,通过集成先进的生成AI技术,打造能够进行流畅、类似人类语音代理的业务世界。

speech-to-speech

speech-to-speech 是一个开源的模块化GPT4-o项目,通过语音活动检测、语音转文本、语言模型和文本转语音等连续部分实现语音到语音的转换。它利用了Transformers库和Hugging Face hub上可用的模型,提供了高度的模块化和灵活性。

whisper-diarization

whisper-diarization是一个结合了Whisper自动语音识别(ASR)能力、声音活动检测(VAD)和说话人嵌入技术的开源项目。它通过提取音频中的声音部分来提高说话人嵌入的准确性,然后使用Whisper生成转录文本,并通过WhisperX校正时间戳和对齐,以减少由于时间偏移导致的分割错误。接着,使用MarbleNet进行VAD和分割以排除静音,TitaNet用于提取说话人嵌入以识别每个段落的说话人,最后将结果与WhisperX生成的时间戳关联,基于时间戳检测每个单词的说话人,并使用标点模型重新对齐以补偿小的时间偏移。

voicechat2

voicechat2是一个基于WebSocket的快速、完全本地化的AI语音聊天应用程序,使用户能够在本地环境中实现语音到语音的即时通讯。它利用了AMD RDNA3显卡和Faster Whisper技术,显著降低了语音通讯的延迟,提高了通讯效率。该产品适用于需要快速响应和实时通讯的开发者和技术人员。

ChatTTS_Speaker

ChatTTS_Speaker是一个基于ERes2NetV2说话人识别模型的实验性项目,旨在对音色进行稳定性评分和音色打标,帮助用户选择稳定且符合需求的音色。项目已开源,支持在线试听和下载音色样本。

sherpa-onnx

sherpa-onnx 是一个基于下一代 Kaldi 的语音识别和语音合成项目,使用onnxruntime进行推理,支持多种语音相关功能,包括语音转文字(ASR)、文字转语音(TTS)、说话人识别、说话人验证、语言识别、关键词检测等。它支持多种平台和操作系统,包括嵌入式系统、Android、iOS、Raspberry Pi、RISC-V、服务器等。

LookOnceToHear

LookOnceToHear 是一种创新的智能耳机交互系统,允许用户通过简单的视觉识别来选择想要听到的目标说话者。这项技术在 CHI 2024 上获得了最佳论文荣誉提名。它通过合成音频混合、头相关传输函数(HRTFs)和双耳房间脉冲响应(BRIRs)来实现实时语音提取,为用户提供了一种新颖的交互方式。

AV-HuBERT

AV-HuBERT是一个自监督表示学习框架,专门用于音视觉语音处理。它在LRS3音视觉语音基准测试中实现了最先进的唇读、自动语音识别(ASR)和音视觉语音识别结果。该框架通过掩蔽多模态聚类预测来学习音视觉语音表示,并且提供了鲁棒的自监督音视觉语音识别。

VSP-LLM

VSP-LLM是一个结合视觉语音处理(Visual Speech Processing)与大型语言模型(LLMs)的框架,旨在通过LLMs的强大能力最大化上下文建模能力。VSP-LLM设计用于执行视觉语音识别和翻译的多任务,通过自监督视觉语音模型将输入视频映射到LLM的输入潜在空间。该框架通过提出一种新颖的去重方法和低秩适配器(LoRA),可以高效地进行训练。

SpeechGPT

SpeechGPT是一种多模态语言模型,具有内在的跨模态对话能力。它能够感知并生成多模态内容,遵循多模态人类指令。SpeechGPT-Gen是一种扩展了信息链的语音生成模型。SpeechAgents是一种具有多模态多代理系统的人类沟通模拟。SpeechTokenizer是一种统一的语音标记器,适用于语音语言模型。这些模型和数据集的发布日期和相关信息均可在官方网站上找到。