产品详情

Awesome-Cluade-Artifacts 是一个GitHub仓库,致力于收集和展示由Anthropic的AI助手Claude在对话中生成的有趣、实质性的内容。这些内容可以是代码片段、Markdown文档、HTML页面、SVG图像、Mermaid图表或React组件等。这个平台鼓励社区成员分享他们认为有趣、有用或有创意的Claude Artifacts,并提供了详细的贡献指南。

主要功能

使用教程

适用人群

目标受众主要是对AI生成内容感兴趣的开发者、设计师和创意工作者。他们可以在这个平台上找到灵感,学习如何使用AI助手来生成各种内容,或者通过共享自己的作品来获得社区的认可和反馈。

使用示例

一个由AI生成的求职助手/CRM系统

一个由AI玩的蛇形游戏

一个具有物理效果的3D游戏

一个未完成的类似蠕虫的全屏游戏

一个输入URL即可生成词云的生成器

一个可调整初始角度以在规则和混沌运动之间切换的双摆物理模拟器

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

Skywork-Reward-Gemma-2-27B

Skywork-Reward-Gemma-2-27B是一个基于Gemma-2-27B架构的先进奖励模型,专为处理复杂场景中的偏好而设计。该模型使用了80K高质量的偏好对数据进行训练,这些数据来源包括数学、编程和安全等多个领域。Skywork-Reward-Gemma-2-27B在2024年9月的RewardBench排行榜上位居第一,展示了其在偏好处理方面的强大能力。

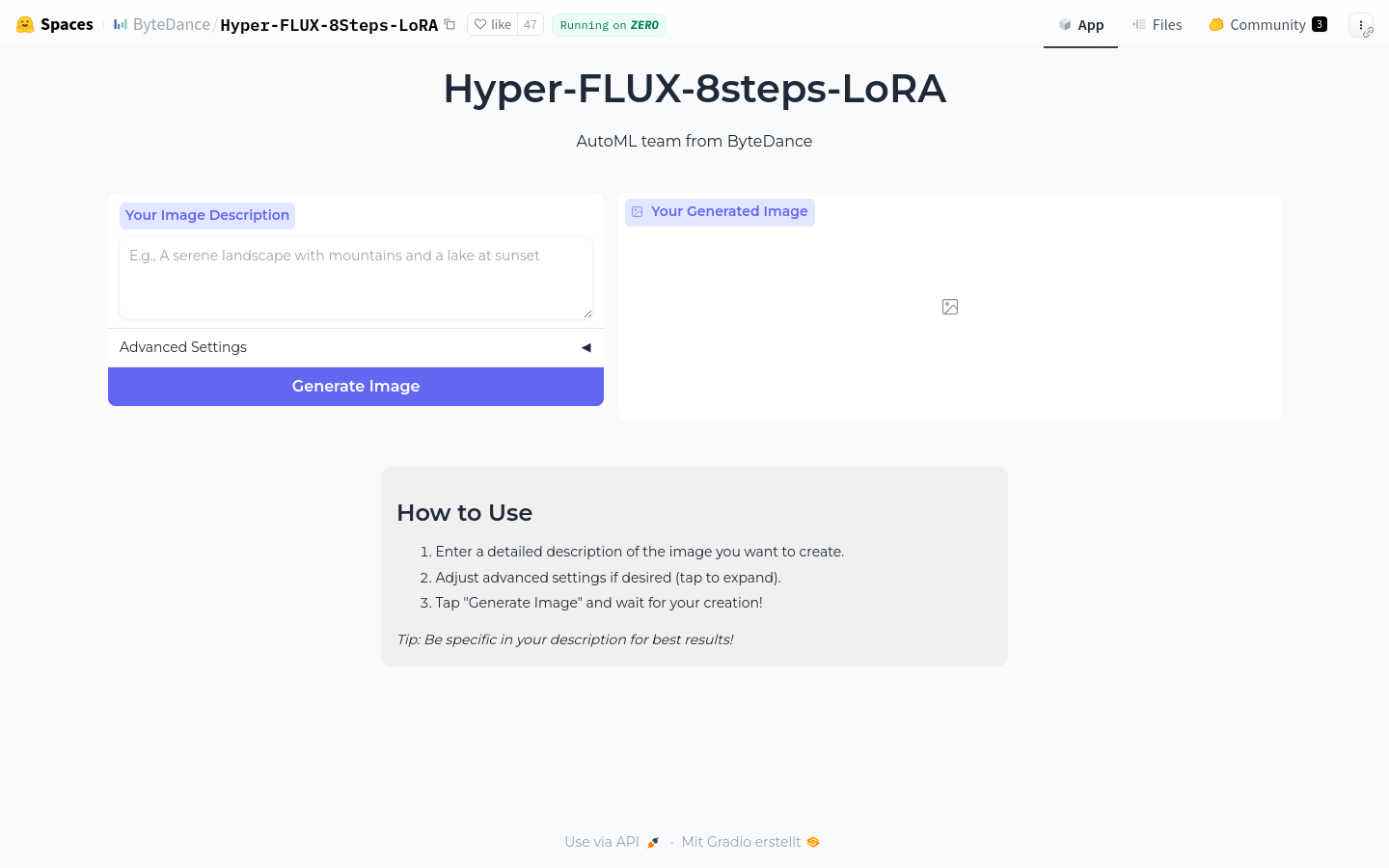

Hyper FLUX 8Steps LoRA

Hyper FLUX 8Steps LoRA是由字节跳动公司开发的一款基于LoRA技术的AI模型,旨在提高模型训练的效率和效果。它通过简化模型结构,减少训练步骤,同时保持或提升模型性能,为AI研究者和开发者提供了一个高效、易用的解决方案。

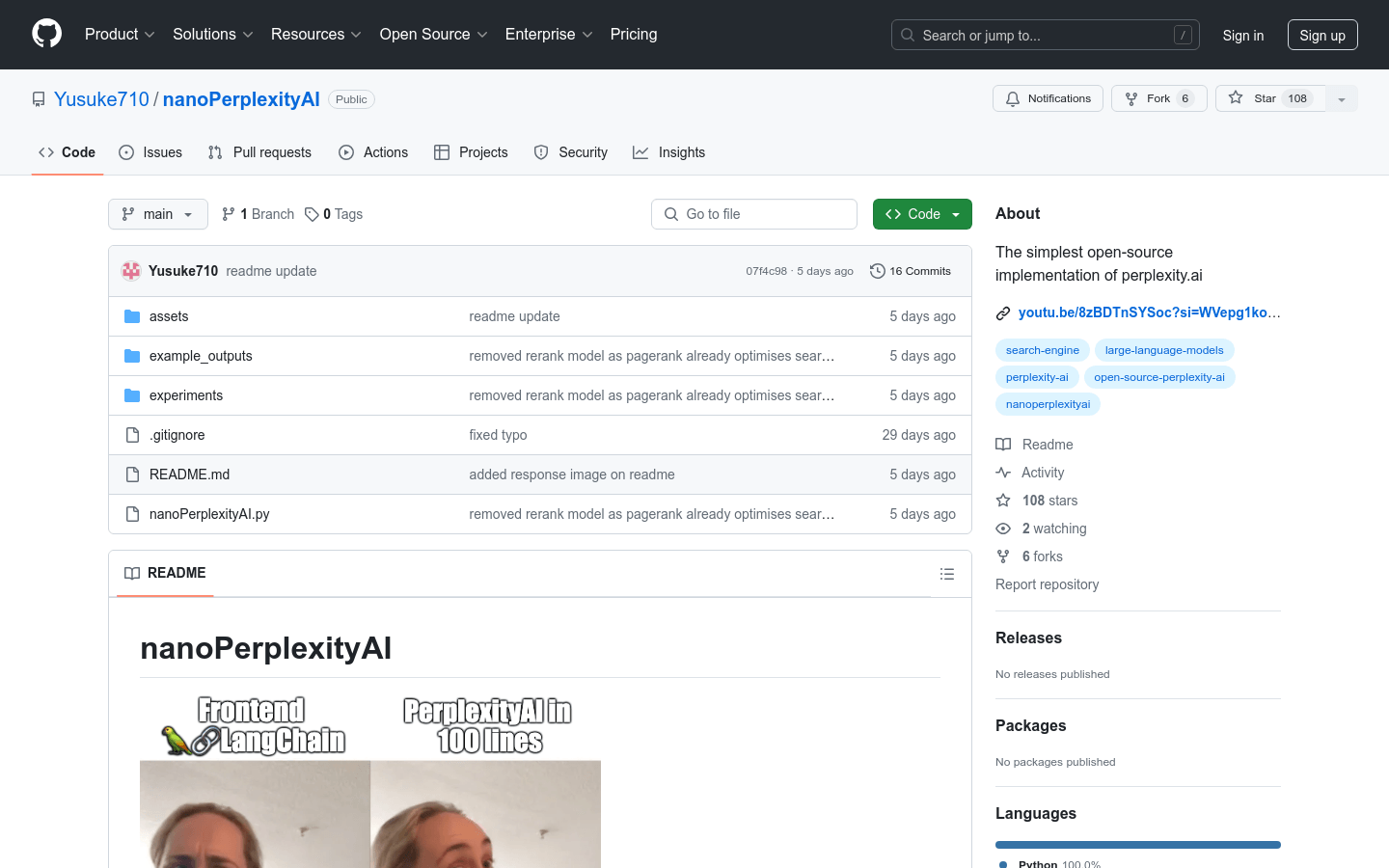

nanoPerplexityAI

nanoPerplexityAI是一个开源的实现,它是一个大型语言模型(LLM)服务,引用Google的信息。没有复杂的GUI或LLM代理,只有100行Python代码。

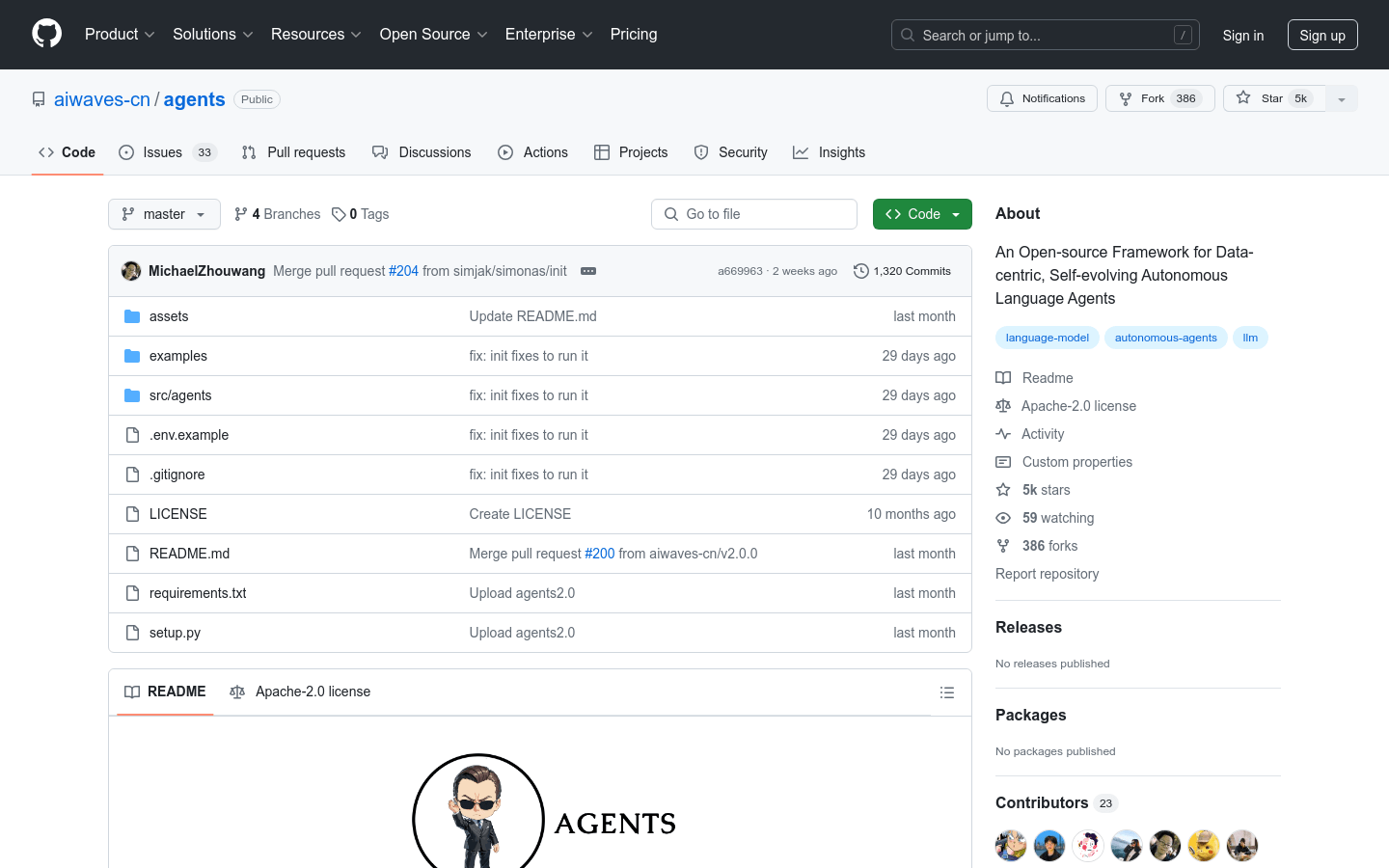

Agents 2.0

aiwaves-cn/agents 是一个开源框架,专注于数据驱动的自适应语言代理。它提供了一种系统化框架,通过符号学习训练语言代理,灵感来源于用于训练神经网络的连接主义学习过程。该框架实现了反向传播和基于梯度的权重更新,使用基于语言的损失、梯度和权重,支持多代理系统的优化。

DiT-MoE

DiT-MoE是一个使用PyTorch实现的扩散变换器模型,能够扩展到160亿参数,与密集网络竞争的同时展现出高度优化的推理能力。它代表了深度学习领域在处理大规模数据集时的前沿技术,具有重要的研究和应用价值。

MInference

MInference是一个针对长上下文大型语言模型(LLMs)的推理加速框架。它利用了LLMs注意力机制中的动态稀疏特性,通过静态模式识别和在线稀疏索引近似计算,显著提升了预填充(pre-filling)的速度,实现了在单个A100 GPU上处理1M上下文的10倍加速,同时保持了推理的准确性。

Expert Specialized Fine-Tuning

Expert Specialized Fine-Tuning (ESFT) 是一种针对具有专家混合(MoE)架构的大型语言模型(LLMs)的高效定制化微调方法。它通过仅调整与任务相关的部分来优化模型性能,提高效率,同时减少资源和存储的使用。

Nemotron-4-340B-Reward

Nemotron-4-340B-Reward是由NVIDIA开发的多维奖励模型,用于合成数据生成管道,帮助研究人员和开发者构建自己的大型语言模型(LLMs)。该模型由Nemotron-4-340B-Base模型和一个线性层组成,能够将响应末尾的标记转换为五个标量值,对应于HelpSteer2属性。它支持最多4096个标记的上下文长度,并能够对每个助手轮次的五个属性进行评分。

Skywork-MoE-Base

Skywork-MoE-Base是一个具有1460亿参数的高性能混合专家(MoE)模型,由16个专家组成,并激活了220亿参数。该模型从Skywork-13B模型的密集型检查点初始化而来,并引入了两种创新技术:门控逻辑归一化增强专家多样化,以及自适应辅助损失系数,允许针对层特定调整辅助损失系数。Skywork-MoE在各种流行基准测试中表现出与参数更多或激活参数更多的模型相当的或更优越的性能。

Skywork-MoE

Skywork-MoE是一个具有146亿参数的高性能混合专家(MoE)模型,包含16个专家和22亿激活参数。该模型从Skywork-13B模型的密集型检查点初始化而来,并引入了两种创新技术:门控逻辑归一化增强专家多样化,以及自适应辅助损失系数允许层特定的辅助损失系数调整。Skywork-MoE在性能上与参数更多或激活参数更多的模型如Grok-1、DBRX、Mistral 8*22和Deepseek-V2相当或更优。

Llama-3 70B Gradient 524K Adapter

Llama-3 70B Gradient 524K Adapter是一个基于Llama-3 70B模型的适配器,由Gradient AI Team开发,旨在通过LoRA技术扩展模型的上下文长度至524K,从而提升模型在处理长文本数据时的性能。该模型使用了先进的训练技术,包括NTK-aware插值和RingAttention库,以高效地在高性能计算集群上进行训练。

SliceGPT

切片GPT是一种新的后训练稀疏化方案,它通过用较小(密集)的矩阵替换每个权重矩阵来减少网络的嵌入维度。通过大量实验,我们展示了切片GPT可以在保持99%、99%和90%的零-shot任务性能的前提下,移除LLAMA2-70B、OPT 66B和Phi-2模型的高达25%的模型参数(包括嵌入)。我们的切片模型在较少的GPU上运行,并且在不进行任何额外代码优化的情况下运行速度更快:在24GB消费级GPU上,我们将LLAMA2-70B的推理总计算量减少到密集模型的64%;在40GB A100 GPU上,我们将其减少到66%。我们提供了一个新的见解,即变压器网络中的计算不变性,这使得切片GPT成为可能。我们希望它能激发并促进未来减少预训练模型的内存和计算需求的新途径。

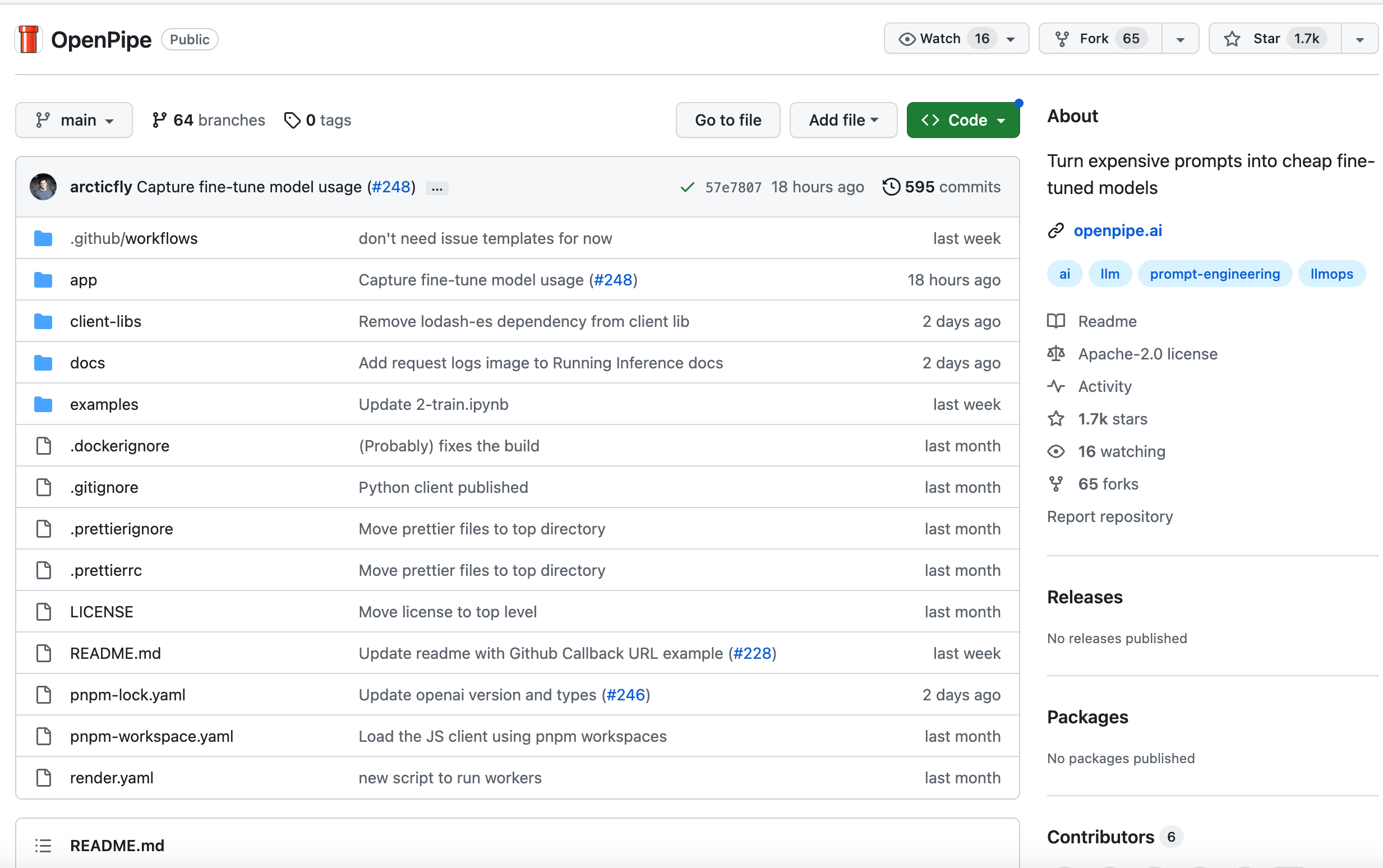

OpenPipe

OpenPipe/OpenPipe 是一个将昂贵的提示转化为廉价的精细调整模型的项目。它通过使用预先训练的模型和自定义训练数据来创建个性化的模型,以实现更高效的文本生成。OpenPipe/OpenPipe 的优势在于它能够为用户提供高质量的文本生成结果,同时降低了训练成本。该项目的定价策略灵活,并提供了多种定价选项以适应不同用户需求。OpenPipe/OpenPipe 的主要功能包括:使用昂贵提示进行训练、生成定制化的模型、高效的文本生成、降低训练成本等。