产品详情

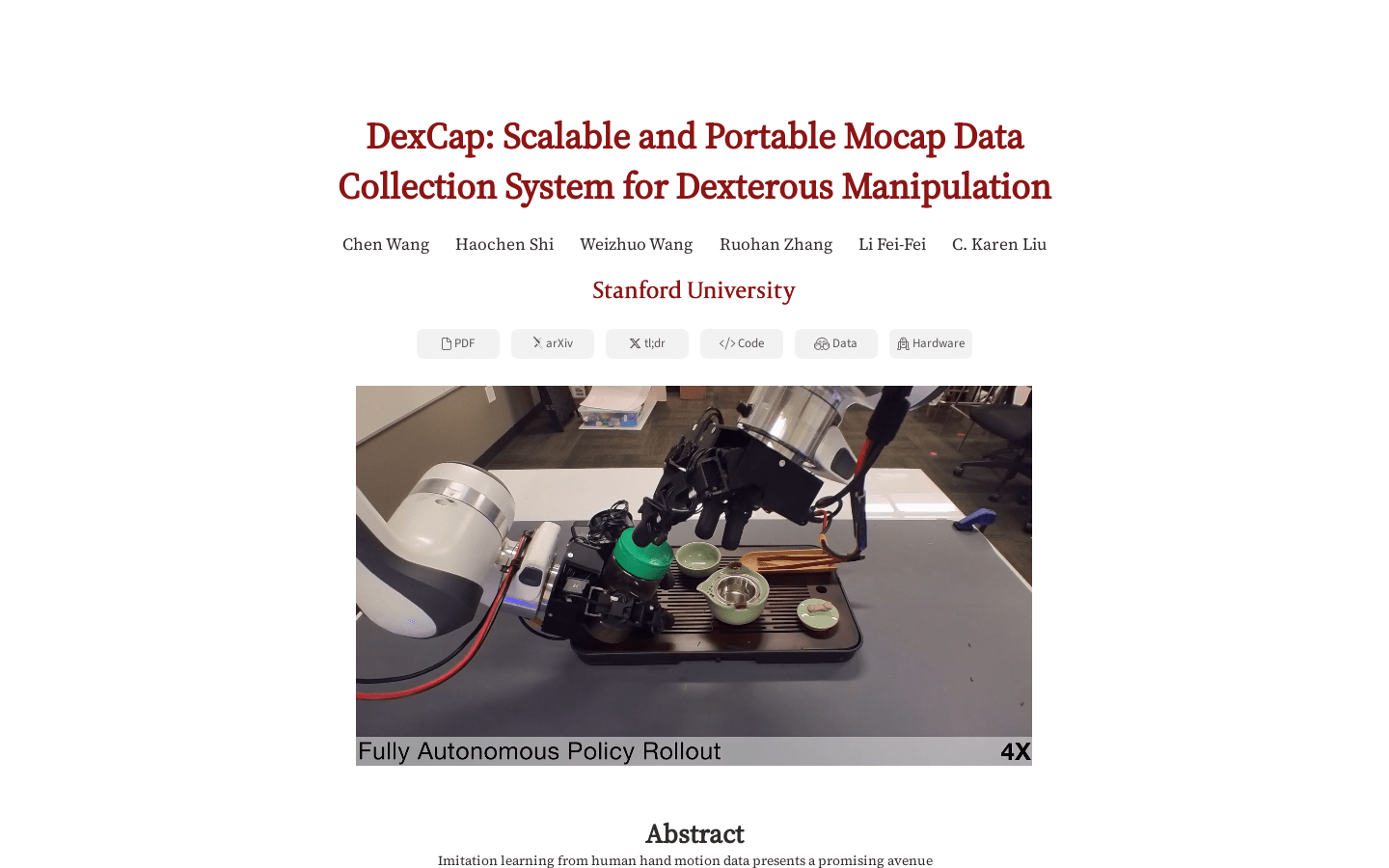

DexCap是一种便携手部动作捕捉系统,结合了全息测距和电磁场技术,提供准确、抗遮挡的手腕和手指运动跟踪,并通过对环境的3D观测进行数据采集。DexIL算法利用逆运动学和基于点云的模仿学习,直接从人类手部动作数据中训练灵巧的机器手技能。系统支持选项的人机协同校正机制,利用这一丰富数据集,机器手能够复制人类动作,还能根据人类手动作进一步提高表现。

主要功能

适用人群

用于训练机器手控制技能,实现人类手部动作的复制。

使用示例

机器手控制技能训练

人类手动作模仿学习

动作数据收集与校正

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

薯图宝

薯图宝是一款旨在提升图文制作效率的批量生成工具,它通过个性化模板和文案数据组合,快速生成大量图片,适用于小红书、抖音、视频号等全平台图文制作。产品背景信息显示,薯图宝能够极大提升生产效率,降低成本,特别适合需要大量图文内容的企业或个人使用。价格方面,提供年卡和永久两种套餐,满足不同用户的需求。

MM1.5

MM1.5是一系列多模态大型语言模型(MLLMs),旨在增强文本丰富的图像理解、视觉指代表明和接地以及多图像推理的能力。该模型基于MM1架构,采用以数据为中心的模型训练方法,系统地探索了整个模型训练生命周期中不同数据混合的影响。MM1.5模型从1B到30B参数不等,包括密集型和混合专家(MoE)变体,并通过广泛的实证研究和消融研究,提供了详细的训练过程和决策见解,为未来MLLM开发研究提供了宝贵的指导。

NVLM-D-72B

NVLM-D-72B是NVIDIA推出的一款多模态大型语言模型,专注于视觉-语言任务,并且通过多模态训练提升了文本性能。该模型在视觉-语言基准测试中取得了与业界领先模型相媲美的成绩。

Llama-3.2-11B-Vision

Llama-3.2-11B-Vision 是 Meta 发布的一款多模态大型语言模型(LLMs),它结合了图像和文本处理的能力,旨在提高视觉识别、图像推理、图像描述和回答有关图像的一般问题的性能。该模型在常见的行业基准测试中的表现超过了众多开源和封闭的多模态模型。

Llama-3.2-90B-Vision

Llama-3.2-90B-Vision是Meta公司发布的一款多模态大型语言模型(LLM),专注于视觉识别、图像推理、图片描述和回答有关图片的一般问题。该模型在常见的行业基准测试中超越了许多现有的开源和封闭的多模态模型。

NVLM

NVLM 1.0是一系列前沿级的多模态大型语言模型(LLMs),在视觉-语言任务上取得了与领先专有模型和开放访问模型相媲美的先进成果。值得注意的是,NVLM 1.0在多模态训练后,其文本性能甚至超过了其LLM主干模型。我们为社区开源了模型权重和代码。

Pixtral-12B-2409

Pixtral-12B-2409是由Mistral AI团队开发的多模态模型,包含12B参数的多模态解码器和400M参数的视觉编码器。该模型在多模态任务中表现出色,支持不同尺寸的图像,并在文本基准测试中保持最前沿的性能。它适用于需要处理图像和文本数据的高级应用,如图像描述生成、视觉问答等。

Pixtral 12B

Pixtral 12B 是 Mistral AI 团队开发的一款多模态 AI 模型,它能够理解自然图像和文档,具备出色的多模态任务处理能力,同时在文本基准测试中也保持了最先进的性能。该模型支持多种图像尺寸和宽高比,能够在长上下文窗口中处理任意数量的图像,是 Mistral Nemo 12B 的升级版,专为多模态推理而设计,不牺牲关键文本处理能力。

即梦AI

即梦AI是一个专为创意爱好者打造的AI表达平台,通过自然语言描述生成独一无二的图片和视频,支持编辑和分享功能,让用户的想象力得到充分展现。深圳市脸萌科技有限公司开发,提供即梦会员订阅服务,享受更多特权。

SEED-Story

SEED-Story是一个基于大型语言模型(MLLM)的多模态长篇故事生成模型,能够根据用户提供的图片和文本生成丰富、连贯的叙事文本和风格一致的图片。它代表了人工智能在创意写作和视觉艺术领域的前沿技术,具有生成高质量、多模态故事内容的能力,为创意产业提供了新的可能性。

BizyAir

BizyAir 是一个由siliconflow开发的插件,旨在帮助用户克服环境和硬件限制,更轻松地使用ComfyUI生成高质量内容。它支持在任何环境下运行,无需担心环境或硬件要求。

Glyph-ByT5-v2

Glyph-ByT5-v2 是微软亚洲研究院推出的一个用于准确多语言视觉文本渲染的模型。它不仅支持10种不同语言的准确视觉文本渲染,而且在美学质量上也有显著提升。该模型通过创建高质量的多语言字形文本和平面设计数据集,构建多语言视觉段落基准,并利用最新的步态感知偏好学习方法来提高视觉美学质量。

AI PhotoCaption

AI PhotoCaption—Text Generator是一款利用先进的GPT-4 Vision技术,自动为用户上传的图片生成吸引人的社交媒体配文的应用程序。它通过分析图片内容,提供多种语言选项,并允许用户选择不同的语气风格,以适应不同社交媒体平台的特点。该应用旨在节省用户时间,提高帖子的参与度,并通过独特的AI增强配文展示用户的创造力,同时实现跨文化沟通。

Phi-3-vision-128k-instruct

Phi-3 Vision是一个轻量级、最先进的开放多模态模型,基于包括合成数据和经过筛选的公开可用网站在内的数据集构建,专注于文本和视觉的非常高质量的推理密集数据。该模型属于Phi-3模型家族,多模态版本支持128K上下文长度(以token计),经过严格的增强过程,结合了监督微调和直接偏好优化,以确保精确的指令遵循和强大的安全措施。

Mini-Gemini

Mini-Gemini是由香港中文大学终身教授贾佳亚团队开发的多模态模型,具备精准的图像理解能力和高质量的训练数据。该模型结合图像推理和生成,提供不同规模的版本,性能与GPT-4和DALLE3相媲美。Mini-Gemini采用Gemini的视觉双分支信息挖掘方法和SDXL技术,通过卷积网络编码图像并利用Attention机制挖掘信息,同时结合LLM生成文本链接两个模型。

EMAGE

EMAGE是一种统一的整体共话手势生成模型,通过表情丰富的掩蔽音频手势建模来生成自然的手势动作。它可以从音频输入中捕捉语音和韵律信息,并生成相应的身体姿势和手势动作序列。EMAGE能够生成高度动态和表现力丰富的手势,从而增强虚拟人物的互动体验。