产品详情

OpenDiT是一个开源项目,提供了一个基于Colossal-AI的Diffusion Transformer(DiT)的高性能实现,专为增强DiT应用(包括文本到视频生成和文本到图像生成)的训练和推理效率而设计。OpenDiT通过以下技术提升性能:在GPU上高达80%的加速和50%的内存减少;包括FlashAttention、Fused AdaLN和Fused layernorm核心优化;包括ZeRO、Gemini和DDP的混合并行方法,还有对ema模型进行分片进一步降低内存成本;FastSeq:一种新颖的序列并行方法,特别适用于DiT等工作负载,其中激活大小较大但参数大小较小;单节点序列并行可以节省高达48%的通信成本;突破单个GPU的内存限制,减少整体训练和推理时间;通过少量代码修改获得巨大性能改进;用户无需了解分布式训练的实现细节;完整的文本到图像和文本到视频生成流程;研究人员和工程师可以轻松使用和调整我们的流程到实际应用中,无需修改并行部分;在ImageNet上进行文本到图像训练并发布检查点。

主要功能

适用人群

用于提升DiT应用的训练和推理效率,包括文本到视频生成和文本到图像生成。

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

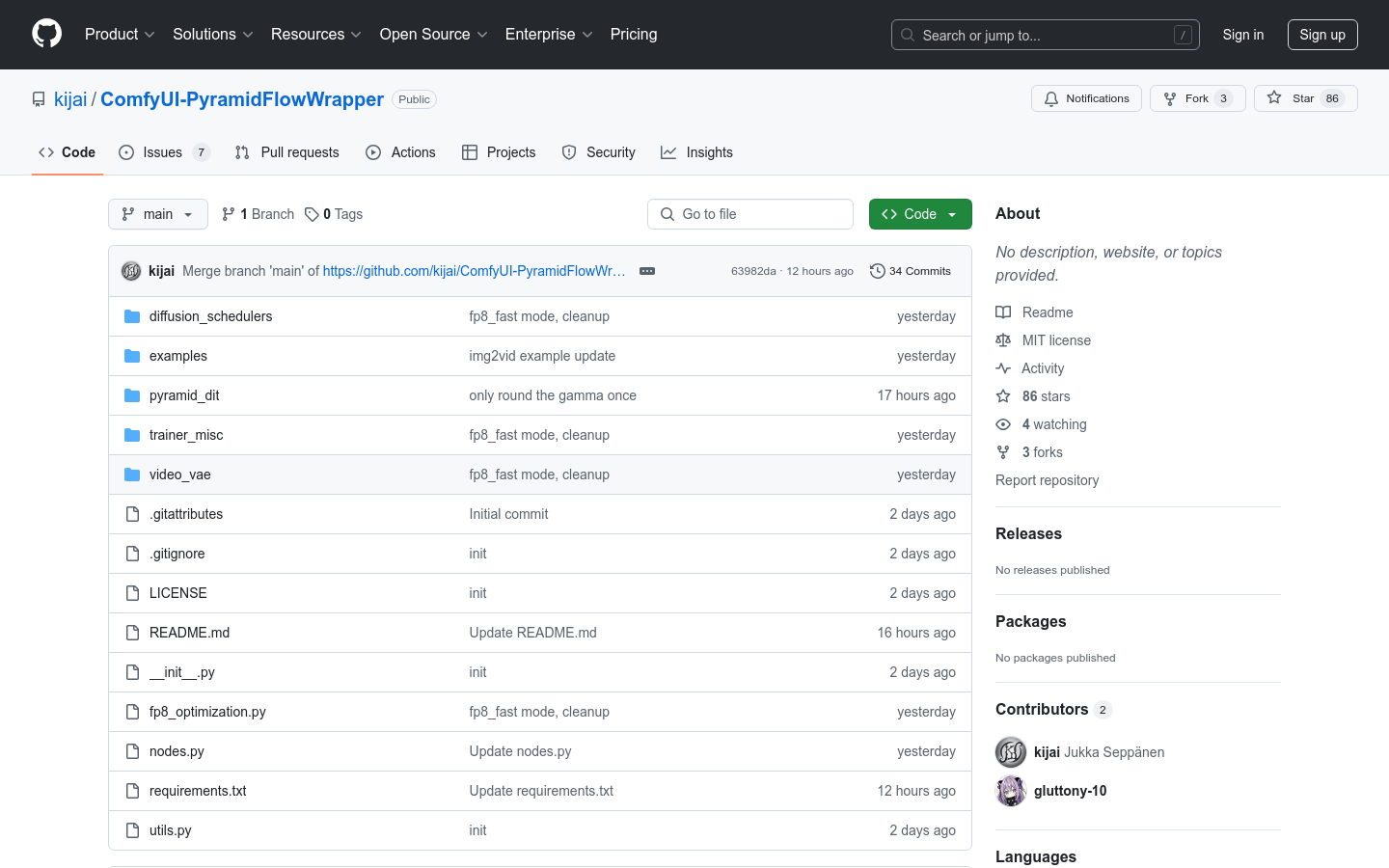

ComfyUI-PyramidFlowWrapper

ComfyUI-PyramidFlowWrapper是基于Pyramid-Flow模型的一套包装节点,旨在通过ComfyUI提供更高效的用户界面和更便捷的操作流程。该模型利用深度学习技术,专注于视觉内容的生成与处理,具有高效处理大量数据的能力。产品背景信息显示,它是由开发者kijai发起并维护的开源项目,目前尚未完全实现功能,但已具备一定的使用价值。由于是开源项目,其价格为免费,主要面向开发者和技术爱好者。

ComfyUI LLM Party

ComfyUI LLM Party旨在基于ComfyUI前端开发一套完整的LLM工作流节点集合,使用户能够快速便捷地构建自己的LLM工作流,并轻松地将它们集成到现有的图像工作流中。

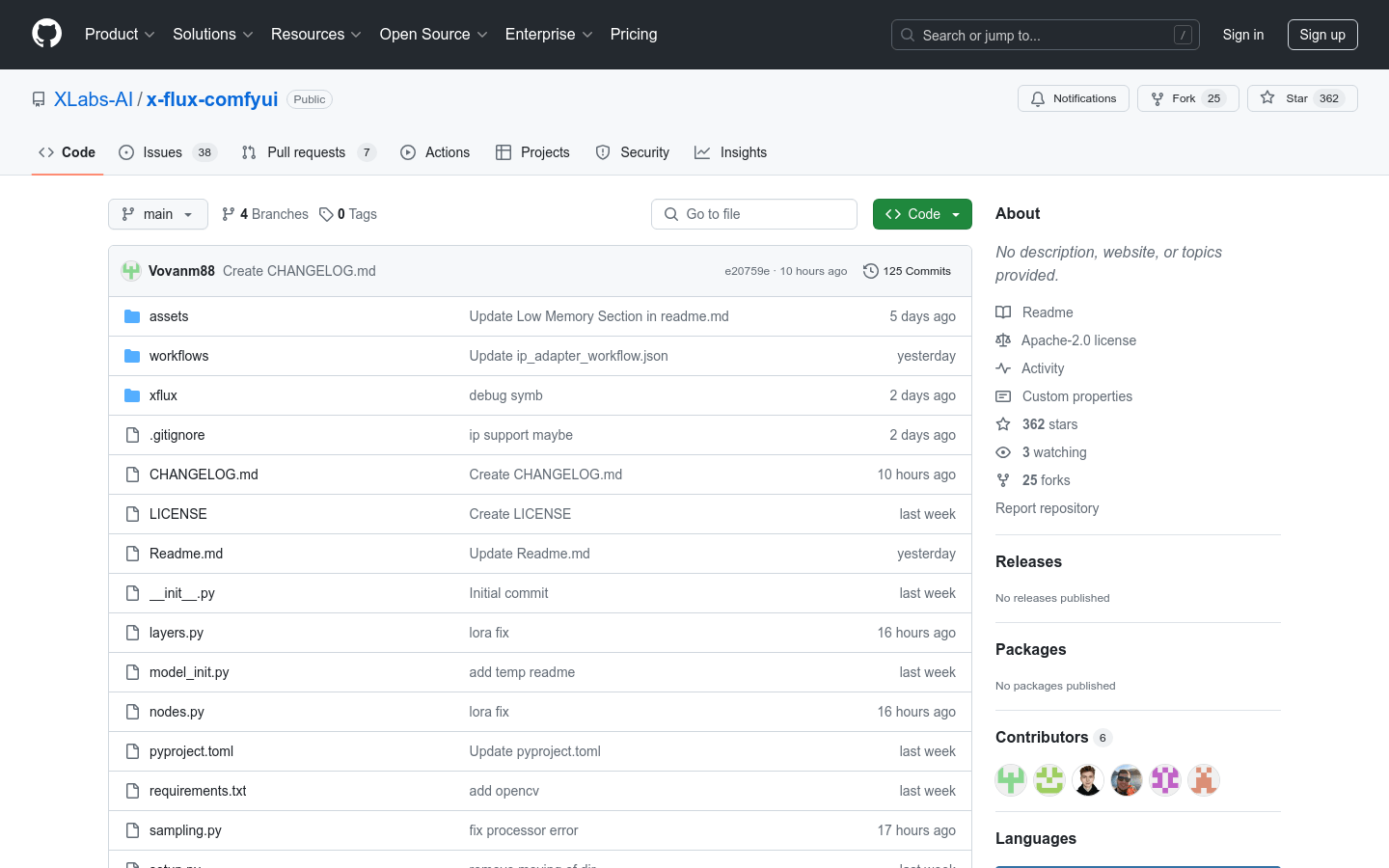

x-flux-comfyui

x-flux-comfyui是一个集成在ComfyUI中的AI模型工具,它提供了多种功能,包括模型训练、模型加载、以及图像处理等。该工具支持低内存模式,可以优化VRAM的使用,适合需要在资源受限的环境中运行AI模型的用户。此外,它还提供了IP Adapter功能,可以与OpenAI的VIT CLIP模型配合使用,增强生成图像的多样性和质量。

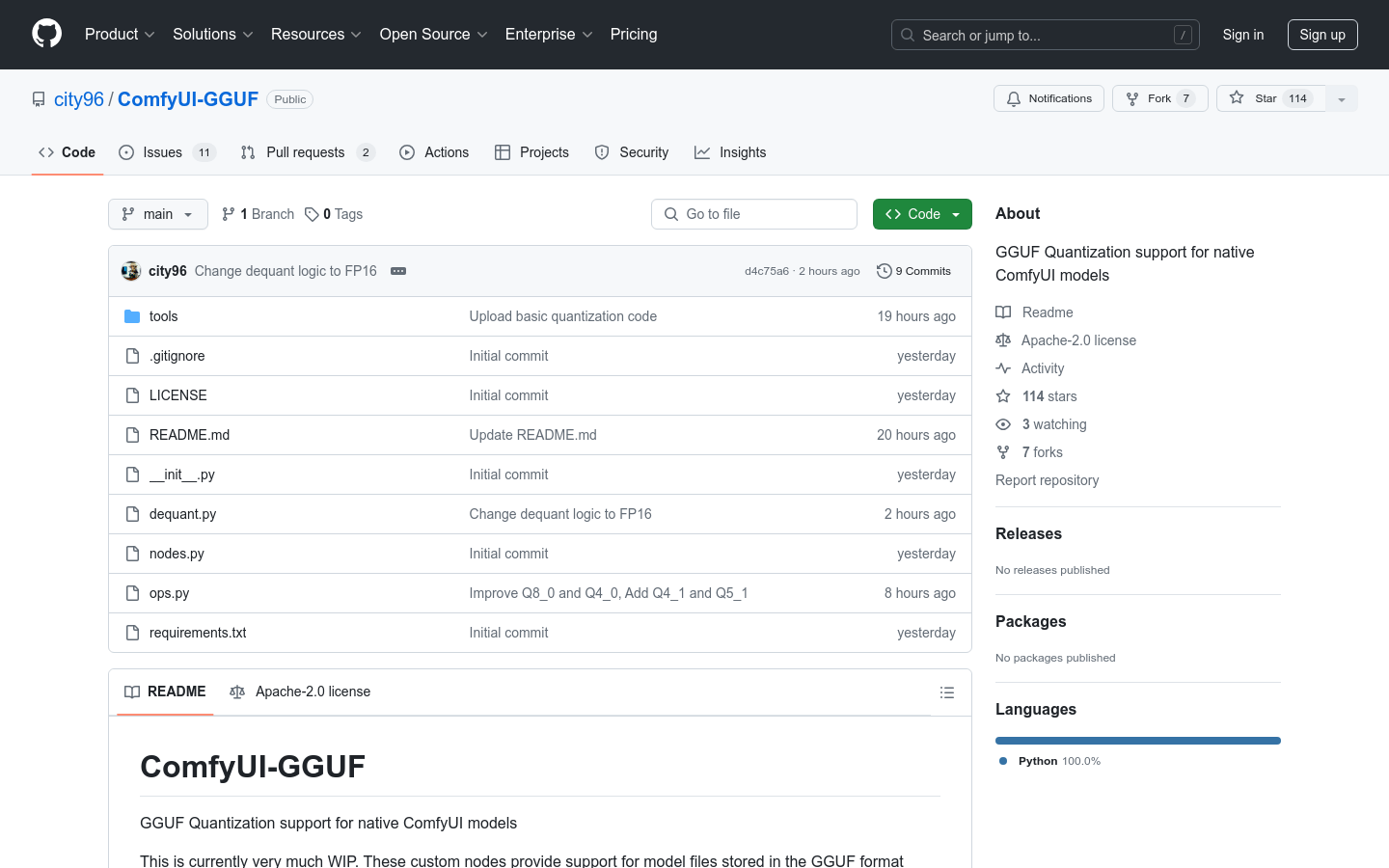

ComfyUI-GGUF

ComfyUI-GGUF是一个为ComfyUI原生模型提供GGUF量化支持的项目。它允许模型文件以GGUF格式存储,这种格式由llama.cpp推广。尽管常规的UNET模型(conv2d)不适用于量化,但像flux这样的transformer/DiT模型似乎受量化影响较小。这使得它们可以在低端GPU上以更低的每权重变量比特率进行运行。

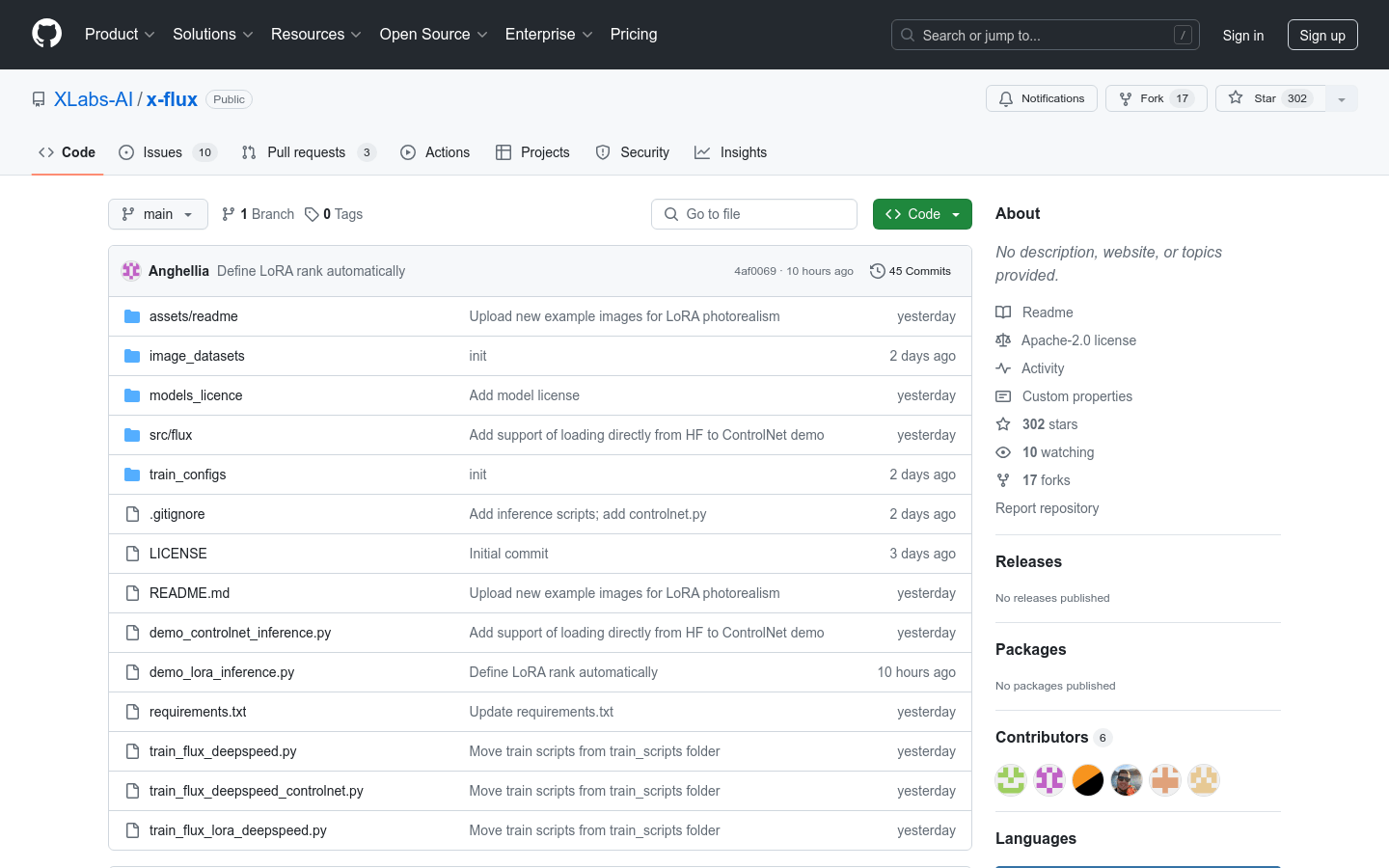

x-flux

x-flux是由XLabs AI团队发布的深度学习模型训练脚本集,包括LoRA和ControlNet模型。这些模型使用DeepSpeed进行训练,支持512x512和1024x1024图片尺寸,并且提供了相应的训练配置文件和示例。x-flux模型训练旨在提高图像生成的质量和效率,对于AI图像生成领域具有重要意义。

Alpha-VLLM

Alpha-VLLM提供了一系列模型,支持从文本到图像、音频等多模态内容的生成。这些模型基于深度学习技术,可以广泛应用于内容创作、数据增强、自动化设计等领域。

ComfyUI-Sub-Nodes

ComfyUI-Sub-Nodes是一个GitHub上的开源项目,旨在为ComfyUI提供子图节点功能。它允许用户在ComfyUI中创建和使用子图,以提高工作流的组织性和复用性。这个插件特别适合需要在UI中进行复杂工作流管理的开发者。

MG-LLaVA

MG-LLaVA是一个增强模型视觉处理能力的机器学习语言模型(MLLM),通过整合多粒度视觉流程,包括低分辨率、高分辨率和以对象为中心的特征。提出了一个额外的高分辨率视觉编码器来捕捉细节,并通过Conv-Gate融合网络与基础视觉特征融合。此外,通过离线检测器识别的边界框整合对象级特征,以进一步细化模型的对象识别能力。MG-LLaVA仅在公开可用的多模态数据上通过指令调优进行训练,展现出卓越的感知技能。

AsyncDiff

AsyncDiff 是一种用于并行化扩散模型的异步去噪加速方案,它通过将噪声预测模型分割成多个组件并分配到不同的设备上,实现了模型的并行处理。这种方法显著减少了推理延迟,同时对生成质量的影响很小。AsyncDiff 支持多种扩散模型,包括 Stable Diffusion 2.1、Stable Diffusion 1.5、Stable Diffusion x4 Upscaler、Stable Diffusion XL 1.0、ControlNet、Stable Video Diffusion 和 AnimateDiff。

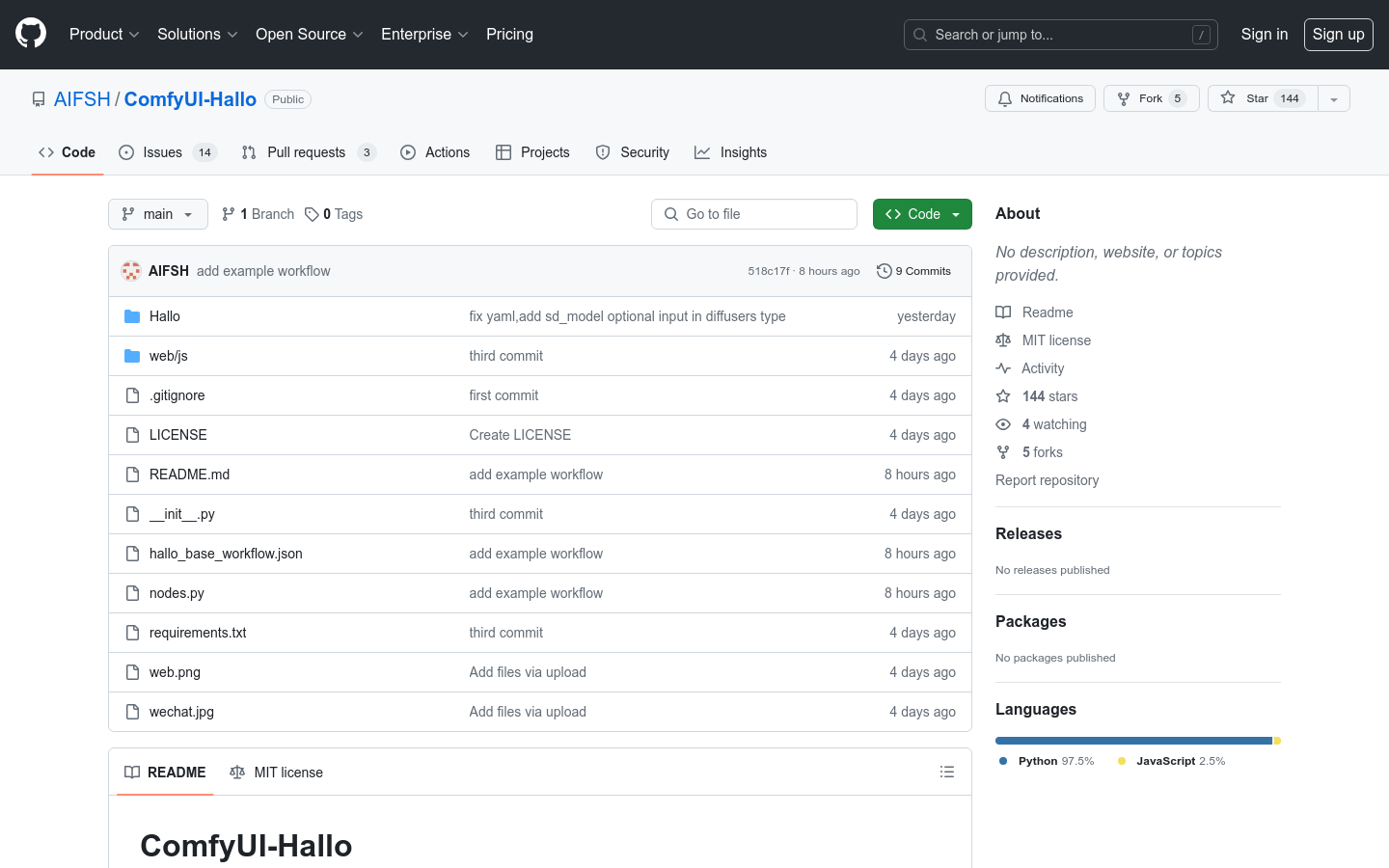

ComfyUI-Hallo

ComfyUI-Hallo是一个为Hallo模型定制的ComfyUI插件,它允许用户在命令行中使用ffmpeg,并从Hugging Face下载模型权重,或者手动下载并放置在指定目录。它为开发者提供了一个易于使用的界面来集成Hallo模型,从而增强了开发效率和用户体验。

ComfyUI-LuminaWrapper

ComfyUI-LuminaWrapper是一个开源的Python包装器,用于简化Lumina模型的加载和使用。它支持自定义节点和工作流,使得开发者能够更便捷地集成Lumina模型到自己的项目中。该插件主要面向希望在Python环境中使用Lumina模型进行深度学习或机器学习的开发者。

EVE

EVE是一个编码器自由的视觉-语言模型,由大连理工大学、北京人工智能研究院和北京大学的研究人员共同开发。它在不同图像宽高比下展现出卓越的能力,性能超越了Fuyu-8B,并且接近模块化编码器基础的LVLMs。EVE在数据效率、训练效率方面表现突出,使用33M公开数据进行预训练,并利用665K LLaVA SFT数据为EVE-7B模型训练,以及额外的1.2M SFT数据为EVE-7B (HD)模型训练。EVE的开发采用了高效、透明、实用的策略,为跨模态的纯解码器架构开辟了新途径。

ComfyUI Ollama

ComfyUI Ollama是为ComfyUI工作流设计的自定义节点,它使用ollama Python客户端,允许用户轻松地将大型语言模型(LLM)集成到他们的工作流程中,或者仅仅是进行GPT实验。这个插件的主要优点在于它提供了与Ollama服务器交互的能力,使得用户可以执行图像查询、通过给定的提示查询LLM,以及使用精细调整参数进行LLM查询,同时保持生成链的上下文。

JavaVision

JavaVision是一个基于Java开发的全能视觉智能识别项目,它不仅实现了PaddleOCR-V4、YoloV8物体识别、人脸识别、以图搜图等核心功能,还可以轻松扩展到其他领域,如语音识别、动物识别、安防检查等。项目特点包括使用SpringBoot框架、多功能性、高性能、可靠稳定、易于集成和灵活可拓展。JavaVision旨在为Java开发者提供一个全面的视觉智能识别解决方案,让他们能够以熟悉且喜爱的编程语言构建出先进、可靠且易于集成的AI应用。

llava-llama-3-8b-v1_1

llava-llama-3-8b-v1_1是一个由XTuner优化的LLaVA模型,它基于meta-llama/Meta-Llama-3-8B-Instruct和CLIP-ViT-Large-patch14-336,并通过ShareGPT4V-PT和InternVL-SFT进行了微调。该模型专为图像和文本的结合处理而设计,具有强大的多模态学习能力,适用于各种下游部署和评估工具包。

MiniGemini

Mini-Gemini是一个多模态视觉语言模型,支持从2B到34B的系列密集和MoE大型语言模型,同时具备图像理解、推理和生成能力。它基于LLaVA构建,利用双视觉编码器提供低分辨率视觉嵌入和高分辨率候选区域,采用补丁信息挖掘在高分辨率区域和低分辨率视觉查询之间进行补丁级挖掘,将文本与图像融合用于理解和生成任务。支持包括COCO、GQA、OCR-VQA、VisualGenome等多个视觉理解基准测试。