产品详情

GenAlt生成在线图像的描述性替代文本,为那些需要的人提供帮助。只需右键单击图像,然后单击“从GenAlt获取替代文本”,即可获得图像的描述作为其替代文本。要查看生成的标题并将其复制到剪贴板上,只需选择“从GenAlt复制AI图像描述”。用户的一些GenAlt见证如下: 1. “GenAlt对我理解照片很有帮助......比现有工具好。”——无障碍倡导者和Twitch主播 2. “GenAlt真的比互联网上的其他应用程序更有帮助,帮助我更好地描述图片。”——高中二年级学生Remi 3. “GenAlt易于使用,有助于让社交媒体对我更具可访问性。”——大学新生Aaron

主要功能

适用人群

用户在浏览网页时,通过使用GenAlt插件,可以轻松获取图像的替代文本,从而提高对图片的可访问性。

使用示例

用户在浏览社交媒体时,使用GenAlt插件获取图片的替代文本。

一个无障碍倡导者使用GenAlt插件来理解照片的内容。

一个高中生在写作文时,使用GenAlt插件来更好地描述图片。

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

Image Describer

Image Describer图像描述生成器是一款利用人工智能技术,通过上传图像并根据用户需求输出图像描述的工具。它能够理解图像内容,并生成详细的描述或解释,帮助用户更好地理解图片含义。这款工具不仅适用于普通用户,还能辅助视障人士通过文本转语音功能了解图片内容。图像描述生成器的重要性在于它能够提升图像内容的可访问性,增强信息的传播效率。

Viewly

Viewly是一款强大的AI图片识别应用,它能够识别图片中的内容,并通过AI技术进行作诗和翻译成多国语言。它代表了当前人工智能在图像识别和语言处理领域的前沿技术,主要优点包括高识别准确率、多语言支持和创造性的AI作诗功能。Viewly的背景信息显示,它是一个持续更新的产品,致力于为用户提供更多创新功能。目前,产品是免费提供给用户的。

PimEyes

PimEyes是一个利用面部识别技术提供反向图片搜索服务的网站,用户可以通过上传照片来查找互联网上与该照片相似的图片或个人信息。这项服务在保护隐私、寻找失踪人口以及版权验证等方面具有重要价值。PimEyes通过其先进的算法,为用户提供了一个强大的工具,以帮助他们在网络上查找和识别图像。

YOLO11

Ultralytics YOLO11是基于之前YOLO系列模型的进一步发展,引入了新特性和改进,以提高性能和灵活性。YOLO11旨在快速、准确、易于使用,非常适合广泛的目标检测、跟踪、实例分割、图像分类和姿态估计任务。

Revisit Anything

Revisit Anything 是一个视觉位置识别系统,通过图像片段检索技术,能够识别和匹配不同图像中的位置。它结合了SAM(Spatial Attention Module)和DINO(Distributed Knowledge Distillation)技术,提高了视觉识别的准确性和效率。该技术在机器人导航、自动驾驶等领域具有重要的应用价值。

Joy Caption Alpha One

Joy Caption Alpha One 是一款基于人工智能的图像描述生成器,能够将图片内容转化为文字描述。它利用深度学习技术,通过理解图片中的物体、场景和动作,生成准确且生动的描述。这项技术在辅助视障人士理解图片内容、增强图片搜索功能以及提升社交媒体内容的可访问性方面具有重要意义。

Open Source Computer Vision Library

OpenCV是一个跨平台的开源计算机视觉和机器学习软件库,它提供了一系列编程功能,包括但不限于图像处理、视频分析、特征检测、机器学习等。该库广泛应用于学术研究和商业项目中,因其强大的功能和灵活性而受到开发者的青睐。

GOT-OCR2.0

GOT-OCR2.0是一个开源的OCR模型,旨在通过一个统一的端到端模型推动光学字符识别技术向OCR-2.0迈进。该模型支持多种OCR任务,包括但不限于普通文本识别、格式化文本识别、细粒度OCR、多裁剪OCR和多页OCR。它基于最新的深度学习技术,能够处理复杂的文本识别场景,并且具有较高的准确率和效率。

bonding_w_geimini

bonding_w_geimini是一个基于Streamlit框架开发的图像处理应用,它允许用户上传图片,通过Gemini API进行物体检测,并在图片上直接绘制出物体的边界框。这个应用利用了机器学习模型来识别和定位图片中的物体,对于图像分析、数据标注和自动化图像处理等领域具有重要意义。

clip-image-search

clip-image-search是一个基于Open AI的预训练CLIP模型的图像搜索工具,能够通过文本或图片查询来检索图片。CLIP模型通过训练将图像和文本映射到同一潜在空间,使得可以通过相似度度量进行比较。该工具使用Unsplash数据集中的图片,并利用Amazon Elasticsearch Service进行k-最近邻搜索,通过AWS Lambda函数和API网关部署查询服务,前端使用Streamlit开发。

Segment Anything 2 for Surgical Video Segmentation

Segment Anything 2 for Surgical Video Segmentation 是一个基于Segment Anything Model 2的手术视频分割模型。它利用先进的计算机视觉技术,对手术视频进行自动分割,以识别和定位手术工具,提高手术视频分析的效率和准确性。该模型适用于内窥镜手术、耳蜗植入手术等多种手术场景,具有高精度和高鲁棒性的特点。

SAM-Graph

SAM-guided Graph Cut for 3D Instance Segmentation是一种利用3D几何和多视图图像信息进行3D实例分割的深度学习方法。该方法通过3D到2D查询框架,有效利用2D分割模型进行3D实例分割,通过图割问题构建超点图,并通过图神经网络训练,实现对不同类型场景的鲁棒分割性能。

SA-V Dataset

SA-V Dataset是一个专为训练通用目标分割模型设计的开放世界视频数据集,包含51K个多样化视频和643K个时空分割掩模(masklets)。该数据集用于计算机视觉研究,允许在CC BY 4.0许可下使用。视频内容多样,包括地点、对象和场景等主题,掩模从建筑物等大规模对象到室内装饰等细节不等。

Segment Anything Model 2

Segment Anything Model 2 (SAM 2)是Meta公司AI研究部门FAIR推出的一个视觉分割模型,它通过简单的变换器架构和流式内存设计,实现实时视频处理。该模型通过用户交互构建了一个模型循环数据引擎,收集了迄今为止最大的视频分割数据集SA-V。SAM 2在该数据集上训练,提供了在广泛任务和视觉领域中的强大性能。

SAM 2

Meta Segment Anything Model 2 (SAM 2)是Meta公司开发的下一代模型,用于视频和图像中的实时、可提示的对象分割。它实现了最先进的性能,并且支持零样本泛化,即无需定制适配即可应用于之前未见过的视觉内容。SAM 2的发布遵循开放科学的方法,代码和模型权重在Apache 2.0许可下共享,SA-V数据集也在CC BY 4.0许可下共享。

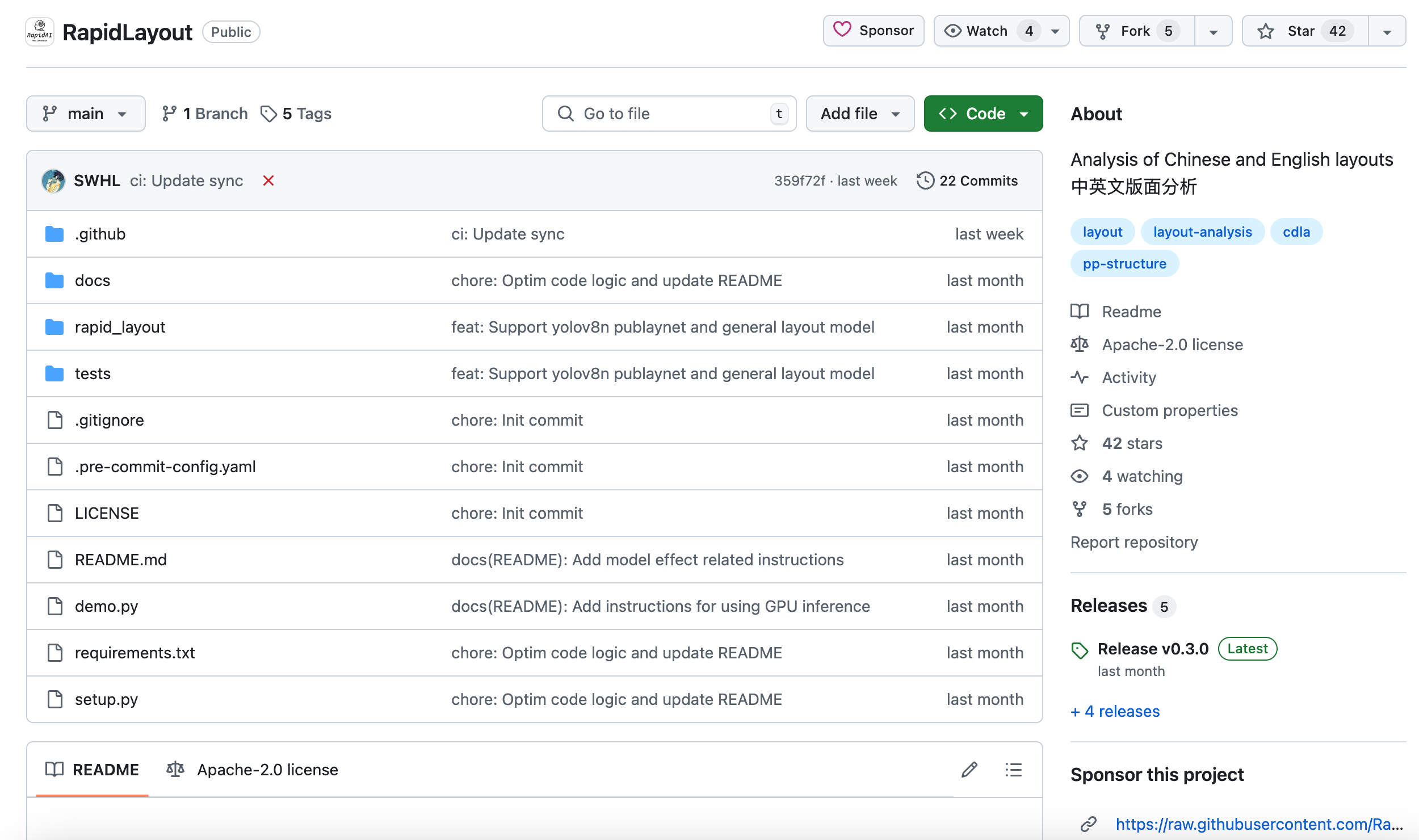

RapidLayout

RapidLayout是一个专注于文档图像版面分析的开源工具,能够对文档类别图像进行版面结构分析,定位标题、段落、表格和图片等各个部分。它支持多种语言和场景的版面分析,包括中文和英文,能够满足不同业务场景的需求。