产品详情

Polyverse是一家总部位于纽约的领先移动应用公司,专注于使用AI技术开发应用和游戏。我们通过创造力和AI技术相结合,开发出具有创新性的应用和游戏,改变人们与设备互动的方式。我们的产品包括AI Mirror、Bricks Royale和Spellai等。AI Mirror是一款AI驱动的图像生成应用,可以将您的照片转化为各种风格的艺术作品。Bricks Royale是一款经典的打砖块游戏,您需要打破各种级别的砖块来拯救国王和公主。Spellai是一款将您的文字转化为照片的AI驱动的应用,您可以使用简单的提示以不同的风格释放您的创造力。我们的产品可广泛应用于娱乐、创意设计、个人化等场景。

主要功能

适用人群

广泛应用于娱乐、创意设计、个人化等场景

使用示例

使用AI Mirror将照片转化为卡通形象

玩Bricks Royale游戏拯救国王和公主

使用Spellai将文字转化为照片的艺术作品

快速访问

访问官网 →所属分类

相关推荐

发现更多类似的优质AI工具

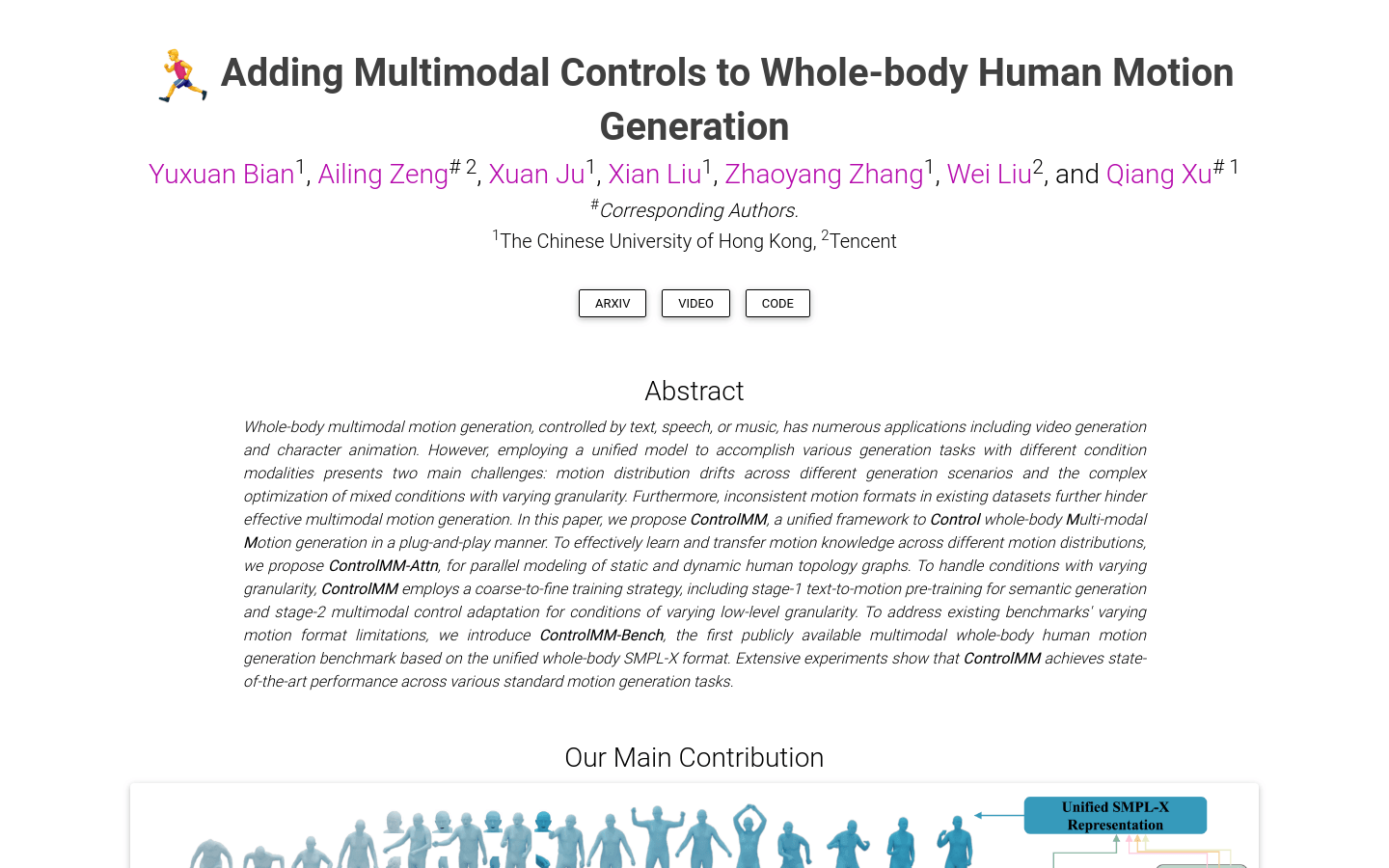

ControlMM

ControlMM是一个全身运动生成框架,具有即插即用的多模态控制功能,能够在文本到运动(Text-to-Motion)、语音到手势(Speech-to-Gesture)和音乐到舞蹈(Music-to-Dance)等多个领域中生成稳健的运动。该模型在可控性、序列性和运动合理性方面具有明显优势,为人工智能领域提供了一种新的运动生成解决方案。

SignLLM

SignLLM是首个多语种手语生成模型,它基于公共手语数据构建,包括美国手语(ASL)和其他七种手语。该模型能够从文本或提示生成手语手势,并通过强化学习加速训练过程,提高数据采样质量。SignLLM在八种手语的生产任务上都达到了最先进的性能。

MagicTime-merged-fp16

MagicTime是将MagicTime时间Lora融合到Animatediff v3动态模型中,以及将其空间Lora转换为.safetensors格式。在ComfyUI和AnimatediffEvolved中一起使用。功能强大,提供高质量的时空融合效果,适用于动态模型应用。定价视具体用途而定,定位于提供先进的时空融合技术。

IMUSIC

IMUSIC是一个基于IMU传感器信号进行面部表情捕捉的新颖系统。它使用经过优化的IMU传感器配置方案和解耦算法,能够仅通过IMU信号准确预测面部Blendshape参数。与基于视觉的传统面部捕捉方案不同,IMUSIC可以在视觉受阻的场景下进行面部捕捉,同时保护用户隐私。

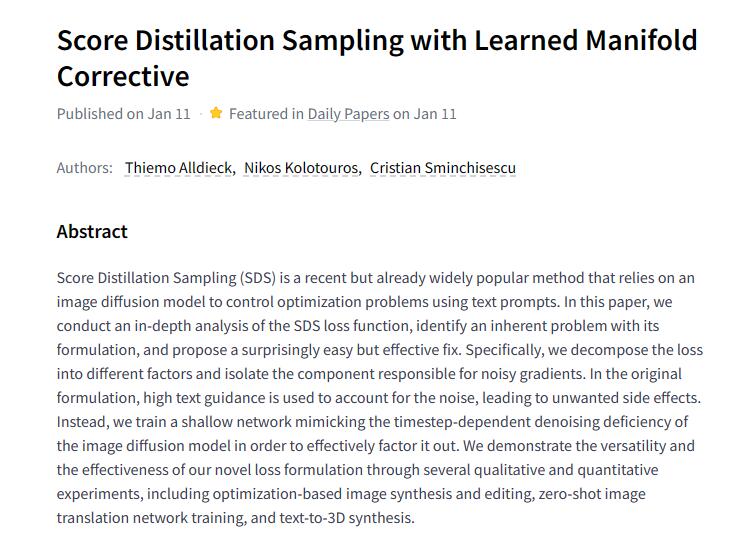

Score Distillation Sampling

Score Distillation Sampling(SDS)是一种新近但已经广泛流行的方法,依赖于图像扩散模型来控制使用文本提示的优化问题。该论文对SDS损失函数进行了深入分析,确定了其制定中的固有问题,并提出了一个出人意料但有效的修复方法。具体而言,我们将损失分解为不同因素,并分离出产生噪声梯度的组件。在原始制定中,使用高文本指导来账户噪声,导致了不良副作用。相反,我们训练了一个浅层网络,模拟图像扩散模型的时间步相关去噪不足,以有效地将其分解出来。我们通过多个定性和定量实验(包括基于优化的图像合成和编辑、零样本图像转换网络训练、以及文本到3D合成)展示了我们新颖损失制定的多功能性和有效性。

Instruct-Imagen

Instruct-Imagen是一个多模态图像生成模型,通过引入多模态指令,实现对异构图像生成任务的处理,并在未知任务中实现泛化。该模型利用自然语言整合不同的模态(如文本、边缘、风格、主题等),标准化丰富的生成意图。通过在预训练文本到图像扩散模型上进行两阶段框架的微调,采用检索增强训练和多样的图像生成任务微调,使得该模型在各种图像生成数据集上的人工评估结果表明,其在领域内与先前的任务特定模型相匹配或超越,并展现出对未知和更复杂任务的有希望的泛化能力。

DL3DV-10K

DL3DV-10K是一个包含超过10000个高质量视频的大规模实景数据集,每个视频都经过人工标注场景关键点和复杂程度,并提供相机姿态、NeRF估计深度、点云和3D网格等。该数据集可用于通用NeRF研究、场景一致性跟踪、视觉语言模型等计算机视觉研究。

aAMUSEd

aMUSEd是一个开源平台,提供各种自然语言处理(NLP)模型、数据集和工具。其中包括aMUSEd,一个基于MUSE的轻量级遮蔽图像模型(MIM),用于文本到图像的生成。相比于潜在扩散(latent diffusion),MIM需要更少的推理步骤并且更易解释。此外,MIM可以通过仅有一张图片进行微调以学习额外的风格。aMUSEd还提供了两个模型的检查点,可以直接生成256x256和512x512分辨率的图像。

Diffusion Model with Perceptual Loss

该论文介绍了一种基于感知损失的扩散模型,通过将感知损失直接纳入扩散训练中来提高样本质量。对于有条件生成,该方法仅改善样本质量而不会影响条件输入,因此不会牺牲样本多样性。对于无条件生成,这种方法也能提高样本质量。论文详细介绍了方法的原理和实验结果。

SteinDreamer

SteinDreamer供文本到3D分数蒸馏的解决方案。他们提出了一种名为Stein Score Distillation (SSD)的方差缩减解决方案,通过控制变量构建和Stein身份,实现了对蒸馏方差的有效降低。他们的实验结果表明,SSD能够有效降低蒸馏方差,并且在对象和场景级别的生成中持续提高视觉质量。此外,他们还展示了SteinDreamer相对于现有方法具有更快的收敛速度。

X-Adapter

X-Adapter是一个通用升级工具,可以使预训练的插件模块(例如ControlNet、LoRA)直接与升级的文本到图像扩散模型(例如SD-XL)配合使用,无需进一步重新训练。通过训练额外的网络来控制冻结的升级模型,X-Adapter保留旧模型的连接器,并添加可训练的映射层以连接不同版本模型的解码器进行特征重映射。重映射的特征将作为升级模型的引导。为了增强X-Adapter的引导能力,我们采用空文本训练策略。在训练后,我们还引入了两阶段去噪策略,以调整X-Adapter和升级模型的初始潜变量。X-Adapter展示了与各种插件的通用兼容性,并使不同版本的插件能够共同工作,从而扩展了扩散社区的功能。我们进行了大量实验证明,X-Adapter可能在升级的基础扩散模型中有更广泛的应用。

Stable Diffusion XL

Stable Diffusion XL是在 TPUv5e 上运行的一个 Hugging Face Space,它提供了稳定扩散 XL 模型的应用。Stable Diffusion XL是一个强大的自然语言处理模型,它在文本生成、问答、语义理解等多个领域有广泛的应用。该模型在 TPUv5e 上运行,具有高效、稳定的特性,能够处理大规模数据和复杂任务。

MiniGPT-5

MiniGPT-5是一个基于生成式vokens的交错式视觉语言生成技术,能够同时生成文字叙述和相关的图像。它采用两阶段训练策略,第一阶段进行无描述的多模态生成训练,第二阶段进行多模态学习。该模型在多模态对话生成任务上取得了良好效果。